در حال حاضر محصولی در سبد خرید شما وجود ندارد.

یک دوره جامع در مورد Spark SQL و همچنین API های قاب داده با استفاده از Scala با دسترسی به آزمایشگاه مکمل

عنوان اصلی : Spark SQL and Spark 3 using Scala Hands-On with Labs

سرفصل های دوره :

مقدمه:

CCA 175 Spark and Hadoop Developer - برنامه درسی

تنظیم محیط با استفاده از AWS Cloud9:

شروع به کار با Cloud9

ایجاد محیط Cloud9

گرم کردن با Cloud9 IDE

نمای کلی EC2 مربوط به Cloud9

باز کردن درگاهها برای Cloud9 Instance

ارتباط IP های الاستیک به نمونه Cloud9

اندازه صدای EBS نمونه Cloud9 را افزایش دهید

آزمایشگاه Jupyter را در Cloud9 راه اندازی کنید

[فرمانها] آزمایشگاه Jupyter را در Cloud9 راهاندازی کنید

تنظیم محیط - مروری بر GCP و Provision Ubuntu VM:

ثبت نام برای GCP

نمای کلی کنسول وب GCP

نمای کلی قیمت گذاری GCP

VM Ubuntu را از GCP تهیه کنید

راه اندازی Docker

چرا ما در حال راه اندازی آزمایشگاه Python و Jupyter برای دوره مرتبط با Scala هستیم؟

اعتبار سنجی پایتون

راه اندازی آزمایشگاه Jupyter

تنظیم Hadoop در خوشه گره تک:

مقدمه ای بر Single Node Hadoop Cluster

پیش نیازهای راه اندازی

[فرمانها] - پیشنیازهای راهاندازی

تنظیم رمز عبور کمتر از ورود به سیستم

[فرمانها] - راهاندازی رمز عبور کمتر از ورود

Hadoop را دانلود و نصب کنید

[فرمانها] - دانلود و نصب Hadoop

Hadoop HDFS را پیکربندی کنید

[فرمانها] - پیکربندی Hadoop HDFS

HDFS را شروع و اعتبار سنجی کنید

[فرمانها] - HDFS را شروع و اعتبار سنجی کنید

Hadoop YARN را پیکربندی کنید

[فرمانها] - Hadoop YARN را پیکربندی کنید

YARN را شروع و اعتبار سنجی کنید

[فرمانها] - YARN را شروع و اعتبار سنجی کنید

مدیریت هدوپ تک گره

[فرمانها] - مدیریت Hadoop تک گره

راه اندازی Hive and Spark در Single Node Cluster:

مجموعه های داده را برای تمرین تنظیم کنید

[فرمانها] - مجموعههای داده را برای تمرین تنظیم کنید

Hive را دانلود و نصب کنید

[Commands] - Hive را دانلود و نصب کنید

پایگاه داده را برای Hive Metastore تنظیم کنید

[فرمانها] - راهاندازی پایگاه داده برای Hive Metastore

Hive Metastore را پیکربندی و راه اندازی کنید

[فرمانها] - Hive Metastore را پیکربندی و راهاندازی کنید

Hive را راه اندازی و اعتبار سنجی کنید

[فرمانها] - Hive را راهاندازی و اعتبارسنجی کنید

اسکریپت هایی برای مدیریت خوشه گره تک

[فرمانها] - اسکریپتهایی برای مدیریت خوشه گره واحد

Spark 2 را دانلود و نصب کنید

[Commands] - Spark 2 را دانلود و نصب کنید

Spark 2 را پیکربندی کنید

[فرمانها] - Spark 2 را پیکربندی کنید

Spark 2 را با استفاده از CLI تأیید کنید

[فرمانها] - Spark 2 را با استفاده از CLI تأیید کنید

تأیید راه اندازی آزمایشگاه Jupyter

[فرمانها] - تأیید اعتبار راهاندازی آزمایشگاه Jupyter

Spark 2 را با Jupyter Lab ادغام کنید

[فرمانها] - Spark 2 را با آزمایشگاه Jupyter ادغام کنید

Spark 3 را دانلود و نصب کنید

[Commands] - Spark 3 را دانلود و نصب کنید

Spark 3 را پیکربندی کنید

[فرمانها] - Spark 3 را پیکربندی کنید

Spark 3 را با استفاده از CLI تأیید کنید

[فرمانها] - Spark 3 را با استفاده از CLI تأیید کنید

Spark 3 را با Jupyter Lab ادغام کنید

[فرمانها] - Spark 3 را با آزمایشگاه Jupyter ادغام کنید

Scala Fundamentals:

Scala را در ویندوز راه اندازی کنید

ساختارهای اصلی برنامه نویسی

توابع

مفاهیم شی گرا - کلاس ها

مفاهیم شی گرا - اشیا

مفاهیم شی گرا - کلاس های موردی

مجموعه ها - Seq، Set و Map

عملیات کاهش نقشه اساسی

تنظیم مجموعه دادهها برای عملیات ورودی/خروجی اولیه

عملیات اولیه ورودی/خروجی و استفاده از Scala Collections API

جلوها

چرخه توسعه - ایجاد فایل برنامه

چرخه توسعه - کد منبع را با استفاده از SBT در jar کامپایل کنید

چرخه توسعه - SBT را در ویندوز راه اندازی کنید

چرخه توسعه - تغییرات را کامپایل کرده و jar را با آرگومان اجرا کنید

چرخه توسعه - راه اندازی IntelliJ با Scala

چرخه توسعه - برنامه Scala را با استفاده از SBT در IntelliJ توسعه دهید

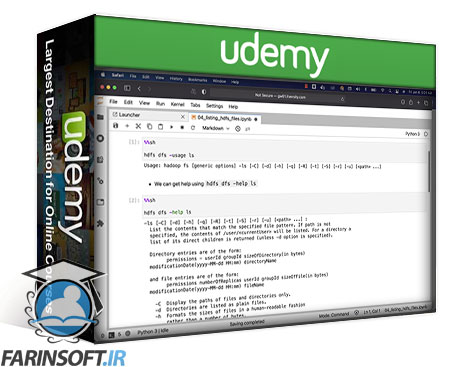

نمای کلی دستورات Hadoop HDFS:

دریافت کمک یا استفاده از دستورات HDFS

فهرست کردن فایل های HDFS

مدیریت دایرکتوری های HDFS

کپی کردن فایل ها از محلی به HDFS

کپی کردن فایل ها از HDFS به محلی

دریافت فراداده فایل

پیش نمایش داده ها در فایل HDFS

اندازه بلوک HDFS

فاکتور تکرار HDFS

دریافت استفاده از فضای ذخیره سازی HDFS

استفاده از دستورات آمار HDFS

مجوزهای فایل HDFS

ویژگی های فراگیر

Apache Spark 2 با استفاده از Scala - Data Processing - Overview:

معرفی ماژول

شروع Spark Context با استفاده از spark-shell

نمای کلی Spark read APIs

پیش نمایش طرحواره و داده با استفاده از Spark API

نمای کلی Spark Data Frame API

نمای کلی توابع برای دستکاری داده ها در Spark Data Frames

نمای کلی Spark Write API

Apache Spark 2 با استفاده از Scala - پردازش داده های ستون با استفاده از توابع از پیش تعریف شده:

مقدمه ای بر توابع از پیش تعریف شده

ایجاد شیء جلسه Spark در نوت بوک

فریم های داده ساختگی را برای تمرین ایجاد کنید

دستههای توابع در ستونهای قاب داده Spark

استفاده از توابع ویژه Spark - col

استفاده از عملکردهای ویژه Spark - روشن شد

دستکاری ستون های رشته با استفاده از توابع Spark - تبدیل حروف و طول

دستکاری ستون های رشته با استفاده از توابع Spark - substring

دستکاری ستون های رشته با استفاده ازتوابع جرقه - تقسیم

دستکاری ستونهای رشته با استفاده از توابع Spark - رشتههای پیوسته

دستکاری ستون های رشته با استفاده از توابع Spark - رشته های بالشتک

دستکاری ستون های رشته با استفاده از توابع Spark - برش کاراکترهای ناخواسته

توابع تاریخ و زمان در Spark - نمای کلی

توابع تاریخ و زمان در Spark - حساب تاریخ

توابع تاریخ و زمان در Spark - با استفاده از trunc و date_trunc

توابع تاریخ و زمان در Spark - با استفاده از date_format و سایر توابع

توابع تاریخ و زمان در Spark - با برچسب زمانی یونیکس سروکار دارد

توابع از پیش تعریف شده در Spark - نتیجه گیری

Apache Spark 2 با استفاده از Scala - Basic Transformations با استفاده از Data Frame:

مقدمه ای بر تبدیل های اساسی با استفاده از API های چارچوب داده

شروع Spark Context

نمای کلی فیلتر کردن با استفاده از Spark Data Frame API

فیلتر کردن داده ها از Spark Data Frames - خواندن داده ها و درک طرحواره

فیلتر کردن داده ها از Spark Data Frames - Task 1 - Equal Operator

فیلتر کردن داده ها از Spark Data Frames - Task 2 - Comparison Operators

فیلتر کردن داده ها از Spark Data Frames - Task 3 - Boolean AND

فیلتر کردن داده ها از Spark Data Frames - Task 4 - IN Operator

فیلتر کردن داده ها از Spark Data Frames - Task 5 - Between and Like

فیلتر کردن داده ها از Spark Data Frames - کار 6 - استفاده از توابع در فیلتر

مشاهده اجمالی تجمعات با استفاده از Spark Data Frame API

نمای کلی مرتبسازی با استفاده از Spark Data Frame API

راه حل - با استفاده از APIهای Spark Data Frame - قسمت 1 شمارش تاخیری دریافت کنید

راه حل - با استفاده از Spark Data Frame APIs - قسمت 2، شمارش تاخیری دریافت کنید

راه حل - دریافت شمارش تاخیر بر اساس تاریخ با استفاده از Spark Data Frame API

Apache Spark 2 با استفاده از Scala - پیوستن به مجموعه داده ها:

مجموعه داده ها را آماده و اعتبار سنجی کنید

شروع جلسه Spark یا Spark Context

مجموعه دادهها را برای اتصال با استفاده از Spark Data Frame API تجزیه و تحلیل کنید

رکوردهای تکراری را از Data Frame با استفاده از Spark Data Frame API حذف کنید

خلاصه تحولات اساسی با استفاده از Spark Data Frame API

پیوستن به مجموعه دادهها با استفاده از Spark Data Frame API - بیانیههای مشکل

نمای کلی اتصالات با استفاده از Spark Data Frame API

Inner Join با استفاده از Spark Data Fr - دریافت تعداد پروازهای خارج شده از فرودگاه های ایالات متحده

عضویت داخلی با استفاده از Spark Data Fram - تعداد پروازهای خارج شده از ایالات متحده را دریافت کنید

پیوستن خارجی با استفاده از Spark Data Frame API - دریافت Aiports - هرگز استفاده نشده است

Apache Spark با استفاده از SQL - شروع به کار:

شروع به کار با Spark SQL - نمای کلی

مروری بر مستندات Spark

راه اندازی و استفاده از Spark SQL CLI

مروری بر ویژگی های Spark SQL

اجرای دستورات سیستم عامل با استفاده از Spark SQL

آشنایی با فهرست Spark Metastore Warehouse

مدیریت پایگاه های داده Spark Metastore

مدیریت جداول Spark Metastore

بازیابی متادیتا جداول Spark Metastore

نقش Spark Metastore یا Hive Metastore

ورزش - شروع کار با Spark SQL

Apache Spark با استفاده از SQL - Basic Transformations :

تبدیل پایه با استفاده از Spark SQL - مقدمه

Spark SQL - نمای کلی

تعریف بیانیه مشکل برای تبدیل های پایه با استفاده از Spark SQL

جداول را با استفاده از Spark SQL آماده یا ایجاد کنید

برگزاری یا انتخاب داده با استفاده از Spark SQL

فیلتر کردن داده ها با استفاده از Spark SQL

پیوستن به جداول با استفاده از Spark SQL - Inner

پیوستن جداول با استفاده از Spark SQL - Outer

جمع آوری داده ها با استفاده از Spark SQL

مرتبسازی دادهها با استفاده از Spark SQL

نتیجه گیری - راه حل نهایی با استفاده از Spark SQL

Apache Spark با استفاده از SQL - Basic DDL و DML:

مقدمه ای بر پایه DDL و DML با استفاده از Spark SQL

جداول Spark Metastore را با استفاده از Spark SQL ایجاد کنید

مروری بر انواع داده برای ستون های جدول Spark Metastore

افزودن نظرات به جداول Spark Metastore با استفاده از Spark SQL

بارگیری داده ها در جداول Spark Metastore با استفاده از Spark SQL - Local

بارگیری داده ها در جداول Spark Metastore با استفاده از Spark SQL - HDFS

بارگیری داده ها در جداول Spark Metastore با استفاده از Spark SQL - Append و Overwrite

ایجاد جداول خارجی در Spark Metastore با استفاده از Spark SQL

جداول متاستور اسپارک مدیریت شده در مقابل جداول متاستور اسپارک خارجی

نمای کلی قالبهای فایل جدول Spark Metastore

جداول و پایگاه داده های متاستور Spark را رها کنید

قطع کردن جداول Spark Metastore

تمرین - جداول متاستور Spark مدیریت شده

Apache Spark با استفاده از SQL - DML و پارتیشن بندی:

آشنایی با DML و پارتیشن بندی جداول Spark Metastore با استفاده از Spark SQL

مقدمه ای بر پارتیشن بندی جداول متاستور Spark با استفاده از Spark SQL

ایجاد جداول Spark Metastore با استفاده از قالب فایل پارکت

بارگذاری در مقابل درج در جداول متاستور Spark با استفاده از Spark SQL

درج داده با استفاده از Stage Spark Metastore Table با استفاده از Spark SQL

ایجاد جداول متاستور Spark پارتیشن شده با استفاده از Spark SQL

افزودن پارتیشن به جداول Spark Metastore با استفاده از Spark SQL

بارگیری داده ها در Spark Metastore پارتیشن بندی شده ما را در جدول قرار می دهدSpark SQL

درج داده ها در پارتیشن های جداول Spark Metastore با استفاده از Spark SQL

استفاده از حالت پارتیشن پویا برای درج داده ها در جداول Spark Metastore

تمرین - جداول متاستور Spark پارتیشن بندی شده با استفاده از Spark SQL

Apache Spark با استفاده از SQL - توابع از پیش تعریف شده:

مقدمه - مروری بر توابع Spark SQL

مروری بر توابع از پیش تعریف شده با استفاده از Spark SQL

اعتبار سنجی توابع با استفاده از Spark SQL

توابع دستکاری رشته با استفاده از Spark SQL

توابع دستکاری تاریخ با استفاده از Spark SQL

مروری بر توابع عددی با استفاده از Spark SQL

تبدیل نوع داده با استفاده از Spark SQL

برخورد با Nulls با استفاده از Spark SQL

استفاده از CASE و WHEN با استفاده از Spark SQL

مثال پرس و جو - تعداد کلمات با استفاده از Spark SQL

Apache Spark با استفاده از SQL - توابع از پیش تعریف شده - تمرینات:

جدول کاربران را با استفاده از Spark SQL آماده کنید

تمرین 1 - تعداد کاربران ایجاد شده در سال را دریافت کنید

تمرین 2 - نام روز تولد کاربران را دریافت کنید

تمرین 3 - دریافت نام و شناسه ایمیل کاربران اضافه شده در سال 2019

تمرین 4 - تعداد کاربران را بر اساس جنسیت بدست آورید

تمرین 5 - 4 رقم آخر شناسه های منحصر به فرد را دریافت کنید

تمرین 6 - تعداد کاربران را بر اساس کد کشور دریافت کنید

Apache Spark با استفاده از SQL - توابع پنجره:

مقدمه ای بر توابع پنجره با استفاده از Spark SQL

پایگاه داده منابع انسانی را در Spark Metastore با استفاده از Spark SQL آماده کنید

مروری بر توابع پنجره با استفاده از Spark SQL

تجمیع با استفاده از توابع Windowing با استفاده از Spark SQL

توابع LEAD یا LAG با استفاده از Spark SQL

دریافت اولین و آخرین مقادیر با استفاده از Spark SQL

رتبه بندی با استفاده از توابع Windowing در Spark SQL

ترتیب اجرای Spark SQL Queries

نمای کلی سوالات فرعی با استفاده از Spark SQL

فیلتر کردن نتایج تابع پنجره با استفاده از Spark SQL

نمونه سناریو با راه حل:

مقدمه ای بر نمونه سناریوها و راه حل ها

بیانات مشکل - دستورالعمل های عمومی

راه اندازی کار - دستورالعمل های عمومی

دریافت تعداد جرم در هر نوع در ماه - درک داده ها

دریافت تعداد جرم در هر نوع در ماه - پیاده سازی منطق - Core API

دریافت تعداد جرم در هر نوع در ماه - پیاده سازی منطق - چارچوب های داده

دریافت تعداد جرم در هر نوع در ماه - اعتبارسنجی خروجی

دریافت مشتریان غیرفعال - با استفاده از Core Spark API (leftOuterJoin)

دریافت مشتریان غیرفعال - با استفاده از Data Frames و SQL

سه جرم برتر را در RESIDENCE دریافت کنید - با استفاده از Core Spark API

سه جرم برتر را در RESIDENCE دریافت کنید - با استفاده از Data Frame و SQL

داده های NYSE را از فرمت فایل متنی به فرمت فایل پارکت تبدیل کنید

دریافت تعداد کلمات - با آرگومان های کنترلی سفارشی، کلیدهای عددی و قالب فایل

Spark SQL and Spark 3 using Scala Hands-On with Labs

در این روش نیاز به افزودن محصول به سبد خرید و تکمیل اطلاعات نیست و شما پس از وارد کردن ایمیل خود و طی کردن مراحل پرداخت لینک های دریافت محصولات را در ایمیل خود دریافت خواهید کرد.

مسلط شدن بر Amazon Redshift و مبحث Serverless

مهندسی دیتا بوسیله سرویس های AWS Analytics

-main-resized.jpg)

کورس کدنویسی Spark SQL and PySpark 3 در زبان پایتون

Master Data Engineering using Azure Data Analytics

مهندسی دیتا : کار با SQL, Python and Spark

مهندسی داده ها با استفاده از Databricks در AWS و Azure

Mastering Databricks SQL Warehouse and Spark SQL

آموزش کدنویسی Apache Spark 2022 و Databricks در آن

Master Data Engineering using GCP Data Analytics