در حال حاضر محصولی در سبد خرید شما وجود ندارد.

ساخت خطوط لوله های مهندسی داده ها با استفاده از ویژگی های اصلی Databricks مانند Spark، Delta Lake، CloudFiles، و غیره

عنوان اصلی : Data Engineering using Databricks on AWS and Azure

سرفصل های دوره :

مقدمه ای بر مهندسی داده با استفاده از Databricks :

منابعی که برای این دوره استفاده می شود کجاست؟

[حتما تماشا کنید] 30 روز ضمانت بازگشت پول، بازخورد و رتبه بندی

شروع با Databricks:

خدمات Azure Databricks را ایجاد کنید

ثبت نام برای Databricks کامل آزمایشی

نمای کلی رابط کاربری Databricks

آپلود داده ها در فایل ها در Databricks.

در پلتفرم Databricks Cluster ایجاد کنید.

مدیریت سیستم فایل با استفاده از نوت بوک

شروع با Databricks در Azure:

شروع با Databricks در Azure - مقدمه

برای حساب Azure ثبت نام کنید

ورود و افزایش سهمیهها برای vCPUهای منطقهای در Azure

فضای کاری Azure Databricks ایجاد کنید

راه اندازی Azure Databricks Workspace یا Cluster

مطالعه سریع رابط کاربری Azure Databricks

خوشه تک گره Databricks Azure را ایجاد کنید

آپلود داده ها با استفاده از رابط کاربری Azure Databricks

مروری بر ایجاد نوت بوک و اعتبارسنجی فایل ها

برنامه Spark را با استفاده از Azure Databricks Notebook توسعه دهید

Spark Jobs را با استفاده از Azure Databricks Notebook اعتبار سنجی کنید

صادرات و واردات نوت بوک های Azure Databricks

خاتمه Azure Databricks Cluster و حذف پیکربندی

با حذف Resource Group، فضای کاری Azure Databricks را حذف کنید

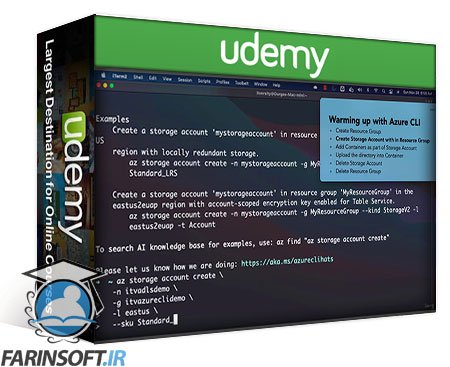

Azure Essentials برای Databricks - Azure CLI:

Azure Essentials برای Databricks - Azure CLI

Azure CLI با استفاده از Azure Portal Cloud Shell

شروع به کار با Azure CLI در مک

شروع با Azure CLI در ویندوز

گرم کردن با Azure CLI - نمای کلی

گروه منابع را با استفاده از Azure CLI ایجاد کنید

ایجاد حساب ذخیره سازی ADLS با در گروه منابع

کانتینر را به عنوان بخشی از حساب ذخیرهسازی اضافه کنید

نمای کلی آپلود داده ها در سیستم فایل یا کانتینر ADLS

تنظیم داده ها به صورت محلی برای آپلود در ADLS File System یا Container

دایرکتوری محلی را در سیستم فایل یا کانتینر Azure ADLS آپلود کنید

حساب ذخیره سازی Azure ADLS را با استفاده از Azure CLI حذف کنید

حذف Azure Resource Group با استفاده از Azure CLI

ADLS را روی Azure Databricks نصب کنید تا به فایلها از Azure Blob Storage دسترسی داشته باشید:

ADLS را روی Azure Databricks نصب کنید - مقدمه

[Material] - ADLS را روی Azure Databricks نصب کنید

از فضای کاری Azure Databricks اطمینان حاصل کنید

Databricks CLI را در مک یا ویندوز با استفاده از محیط مجازی پایتون راه اندازی کنید

Databricks CLI را برای فضای کاری جدید Azure Databricks پیکربندی کنید

یک برنامه Azure Active Directory را ثبت کنید

Databricks Secret را برای AD Application Client Secret ایجاد کنید

ایجاد حساب ذخیره سازی ADLS

نقش IAM در حساب ذخیره سازی را به برنامه Azure AD اختصاص دهید

تنظیم مجموعه داده خرده فروشی DB

ظرف یا سیستم فایل ADLS ایجاد کنید و داده ها را آپلود کنید

Databricks Cluster را برای نصب ADLS راه اندازی کنید

حساب ذخیره سازی ADLS را روی Azure Databricks نصب کنید

نقطه کوه ADLS را در خوشه های Databricks Azure اعتبار سنجی کنید

نقطه اتصال را از Databricks جدا کنید

حذف گروه منبع Azure مورد استفاده برای نصب ADLS بر روی Azure Databricks

تنظیم محیط توسعه محلی:

Databricks Connect را نصب کنید

Databricks Connect را پیکربندی کنید

ادغام Pycharm با Databricks Connect

کد - ادغام Pycharm با Databricks Connect

ادغام خوشه Databricks با کاتالوگ چسب

Setup s3 Bucket and Grant Permissions

نصب سطل های s3 در خوشه های Databricks

استفاده از dbutils از IDE هایی مانند Pycharm

کد - استفاده از dbutils از IDEهایی مانند Pycharm

استفاده از Databricks CLI:

مقدمه

Databricks CLI را نصب و پیکربندی کنید

تعامل با سیستم فایل با استفاده از CLI.

دریافت جزئیات خوشه با استفاده از CLI

چرخه عمر توسعه برنامه Spark:

[فرمانها] - محیط مجازی را راهاندازی کنید و Pyspark را نصب کنید

شروع با Pycharm

[کد و دستورالعمل] - شروع به کار با Pycharm

گذراندن آرگومان های زمان اجرا

دسترسی به متغیرهای محیط سیستم عامل

شروع با Spark

ایجاد تابع برای Spark Session

[Code and Instructions] - ایجاد تابع برای Spark Session

تنظیم داده های نمونه

دادهها را از فایلها بخوانید

[کد و دستورالعمل ها] - خواندن داده ها از فایل ها

پردازش داده ها با استفاده از Spark API

[Code and Instructions] - پردازش داده ها با استفاده از Spark API

داده ها را در فایل ها بنویسید

[کد و دستورالعمل ها] - داده ها را در فایل ها بنویسید

اعتبار سنجی نوشتن داده ها در فایل ها

[کد و دستورالعمل] - تولید کد

تنظیم داده ها برای اعتبارسنجی تولید

شغل ها و خوشه های داده ها:

مقدمه ای بر مشاغل و خوشه ها

ایجاد Pool در پلتفرم Databricks

ایجاد Cluster در Azure Databricks

درخواست افزایش سهمیه CPU در Azure

ایجاد شغل در Databricks

ارسال مشاغل با استفاده از Job Cluster

ایجاد Pool در Databricks

اجرای کار با استفاده از خوشه تعاملی متصل به استخر

اجرای کار با استفاده از خوشه شغلی متصل به استخر

تمرین - درخواست را ارسال کنیدبه عنوان کار با استفاده از خوشه تعاملی

استقرار و اجرا بر روی Databricks:

PyCharm را برای Databricks آماده کنید

مجموعه داده ها را آماده کنید

فایل ها را به ghactivity منتقل کنید

کد Refactor برای Databricks

اعتبار سنجی داده ها با استفاده از Databricks

تنظیم مجموعه داده برای استقرار تولید

با استفاده از dbutils به فراداده فایل دسترسی پیدا کنید

ساخت بسته نرم افزاری قابل توسعه برای Databricks

اجرای مشاغل با استفاده از Databricks Web UI.

جزئیات شغل و اجرای را با استفاده از Databricks CLI دریافت کنید

ارائه مشاغل Databricks با استفاده از CLI

راه اندازی و اعتبارسنجی Databricks Client Library

بازنشانی کار با استفاده از Jobs API

Databricks Job را به صورت برنامه نویسی با استفاده از پایتون اجرا کنید

اعتبار سنجی تفصیلی داده ها

استقرار مشاغل با استفاده از نوت بوک:

مدولار کردن نوت بوک ها

اجرای کار با استفاده از نوت بوک

برنامه Refactor به عنوان نوت بوک Databricks

Notebook را با استفاده از توسعه Cluster اجرا کنید

غواصی عمیق در دریاچه دلتا با استفاده از Data Frame:

معرفی دریاچه دلتا با استفاده از Data Frames

ایجاد چارچوب های داده برای دریاچه دلتا

نوشتن قاب داده با استفاده از قالب دلتا

به روز رسانی داده های موجود با استفاده از قالب دلتا

داده های موجود را با استفاده از قالب دلتا حذف کنید

ادغام یا اضافه کردن داده ها با استفاده از قالب دلتا

حذف با استفاده از Merge در دریاچه دلتا

در بازیابی عکس فوری با استفاده از دلتا لاگ ها اشاره کنید

حذف فایل های دلتا غیر ضروری با استفاده از خلاء

تراکم فایل های دریاچه دلتا

غواصی عمیق در دریاچه دلتا با استفاده از Spark SQL:

معرفی دریاچه دلتا با استفاده از SQL

ایجاد چارچوب های داده برای دریاچه دلتا

جدول دریاچه دلتا را ایجاد کنید

درج داده ها به جدول دریاچه دلتا

بهروزرسانی دادهها در جدول دریاچه دلتا

حذف داده ها از جدول دریاچه دلتا

داده ها را در جدول دریاچه دلتا ادغام یا اضافه کنید

استفاده از تابع ادغام روی جدول دریاچه دلتا

نقطه در بازیابی عکس فوری با استفاده از جدول دریاچه دلتا

جاروبرقی جداول دریاچه دلتا

تراکم جداول دریاچه دلتا

دسترسی به پایانه کلاستر Databricks از طریق وب و همچنین SSH:

ترمینال وب را در کنسول مدیریت Databricks فعال کنید

ترمینال وب را برای Databricks Cluster راه اندازی کنید

SSH را برای Databricks Cluster Driver Node تنظیم کنید

اعتبار اتصال SSH به گره درایور Databricks در AWS

محدودیت های SSH و مقایسه با ترمینال وب

نصب نرم افزارها بر روی Databricks Cluster با استفاده از اسکریپت های init:

gen_logs را در Databricks Cluster تنظیم کنید

[فرمانها] gen_logs را در Databricks Cluster تنظیم کنید

نمای کلی اسکریپت های Init برای Databricks Cluster

اسکریپت برای نصب نرم افزار از git در Databricks Cluster ایجاد کنید

[Commands] برای نصب نرم افزار از git در Databricks Cluster اسکریپت ایجاد کنید

اسکریپت init را در مکان dbfs کپی کنید

[فرمانها] اسکریپت init را در مکان dbfs کپی کنید

خوشه مستقل Databricks را با اسکریپت init ایجاد کنید

بازنگری سریع جریان ساختار یافته Spark:

Netcat را در Databricks Driver Node تأیید کنید

پیام های گزارش را به وب سرور Netcat در Databricks Driver Node فشار دهید

خواندن گزارشهای وب سرور با استفاده از Spark Structured Streaming

نوشتن داده های جریانی در فایل ها

بارهای افزایشی با استفاده از جریان ساختاری جرقه:

نمای کلی جریان ساختار یافته اسپارک

مراحل پردازش اطلاعات افزایشی

Cluster را با Instance Profile.mp4 پیکربندی کنید

فایل های GHAArchive را در s3 آپلود کنید

دادههای JSON را با استفاده از Spark Structured Streaming بخوانید

با استفاده از قالب فایل دلتا با استفاده از Trigger Once بنویسید

داده های GHAArchive را در فایل های دلتا با استفاده از Spark تجزیه و تحلیل کنید

فایل های جدید GHActivity JSON را اضافه کنید

بارگذاری تدریجی داده ها در جدول هدف

تأیید بار افزایشی

موارد داخلی پردازش فایل جریانی ساختاریافته Spark

بارهای افزایشی با استفاده از Cloud Files:

مشاهده اجمالی Auto Loader cloudFiles

فایل های GHAArchive را در s3 آپلود کنید

دادهها را با استفاده از Auto Loader cloudFiles بنویسید

فایل های جدید GHActivity JSON را اضافه کنید

بارگذاری تدریجی داده ها در جدول هدف

فایل های جدید GHActivity JSON را اضافه کنید

مروری بر مدیریت رویدادهای S3 با استفاده از خدمات AWS

نقش IAM را برای اعلانهای فایل cloudFiles پیکربندی کنید

بارگذاری افزایشی با استفاده از اعلانهای فایل cloudFiles

خدمات AWS را برای اعلانهای رویداد cloudFiles مرور کنید

فراداده ایجاد شده برای CloudFiles Checkpointing را مرور کنید

نمای کلی Databricks SQL Cluster:

نمای کلی Databricks SQL Platform - مقدمه

First Query را با استفاده از ویرایشگر SQL Databricks SQL اجرا کنید

نمای کلی داشبوردها با استفاده از Databricks SQL

نمای کلی Databricks SQL Data Explorer برای بررسی پایگاه داده و جداول متاستور

از Databricks SQL Editor برای توسعه اسکریپت ها یا پرس و جوها استفاده کنید

فراداده جداول را با استفاده از Databricks SQL Platform مرور کنید

نمای کلی بارگیری داده ها در جداول retail_db

Databricks CLI را پیکربندی کنید تا داده ها را به پایگاه Databricks منتقل کند

داده های JSON را با استفاده از Databricks CLI در DBFS کپی کنید

دادههای JSON را با استفاده از Spark API تجزیه و تحلیل کنید

طرحواره های جدول دلتا را با استفاده از Spark API تجزیه و تحلیل کنید

بارگذاری داده ها از Spark Data Frames درجداول دلتا

Adhoc Queries را با استفاده از Databricks SQL Editor برای اعتبارسنجی داده ها اجرا کنید

نمای کلی جداول خارجی با استفاده از Databricks SQL

استفاده از دستور COPY برای کپی داده ها در جداول دلتا

مدیریت Databricks SQL Endpoints

Data Engineering using Databricks on AWS and Azure

در این روش نیاز به افزودن محصول به سبد خرید و تکمیل اطلاعات نیست و شما پس از وارد کردن ایمیل خود و طی کردن مراحل پرداخت لینک های دریافت محصولات را در ایمیل خود دریافت خواهید کرد.

مهندسی دیتا بوسیله سرویس های AWS Analytics

Master Data Engineering using Azure Data Analytics

Mastering Databricks SQL Warehouse and Spark SQL

آموزش کدنویسی Apache Spark 2022 و Databricks در آن

مهندسی دیتا : کار با SQL, Python and Spark

Master Data Engineering using GCP Data Analytics

مسلط شدن بر Amazon Redshift و مبحث Serverless

-main-resized.jpg)

کورس کدنویسی Spark SQL and PySpark 3 در زبان پایتون

فیلم یادگیری کامل Spark SQL, Spark 3 و استفاده از Scala