در حال حاضر محصولی در سبد خرید شما وجود ندارد.

خطوط لوله مهندسی داده را با استفاده از خدمات AWS Analytics مانند Glue ، EMR ، Athena ، Kinesis ، Lambda و غیره بسازید

عنوان اصلی : Data Engineering Master Class using AWS Analytics Services

سرفصل های دوره :

معرفی دوره :

مقدمه ای بر مهندسی داده با استفاده از خدمات AWS Analytics

سخنرانی های ویدئویی و مواد مرجع

شرکت در دوره Udemy برای کاربران جدید Udemy

هزینه های اضافی برای زیرساخت AWS برای تمرین عملی

برای حساب AWS ثبت نام کنید

ورود به حساب AWS

مروری بر داشبورد صورتحساب AWS - کاوشگر هزینه و بودجه

تنظیم محیط توسعه محلی برای AWS در ویندوز 10 یا ویندوز 11:

تنظیم محیط محلی در ویندوز برای AWS

نمای کلی Powershell در ویندوز 10 یا ویندوز 11

اوبونتو VM را در ویندوز 10 یا 11 با استفاده از wsl راه اندازی کنید

راه اندازی Ubuntu VM در ویندوز 10 یا 11 با استفاده از wsl - Contd...

Python venv و pip را در اوبونتو راه اندازی کنید

AWS CLI را در ویندوز و اوبونتو با استفاده از Pip راه اندازی کنید

اطلاعات کاربری و دانلود AWS IAM را ایجاد کنید

AWS CLI را در ویندوز پیکربندی کنید

محیط مجازی پایتون را برای پروژه های AWS ایجاد کنید

Boto3 را به عنوان بخشی از محیط مجازی پایتون راه اندازی کنید

آزمایشگاه Jupyter را راه اندازی کنید و boto3 را تأیید کنید

تنظیم محیط توسعه محلی برای AWS در Mac:

تنظیم محیط محلی برای AWS در Mac

AWS CLI را در Mac راه اندازی کنید

کاربر AWS IAM را برای پیکربندی AWS CLI تنظیم کنید

AWS CLI را با استفاده از اعتبار کاربری IAM پیکربندی کنید

راه اندازی محیط مجازی پایتون در مک با استفاده از پایتون 3

Boto3 را به عنوان بخشی از محیط مجازی پایتون راه اندازی کنید

آزمایشگاه Jupyter را راه اندازی کنید و boto3 را تأیید کنید

تنظیم محیط برای تمرین با استفاده از Cloud9:

مقدمه ای بر Cloud9

راه اندازی Cloud9

نمای کلی Cloud9 IDE

Docker و AWS CLI در Cloud9

Cloud9 و EC2

دسترسی به برنامه های کاربردی وب

تخصیص و اختصاص IP استاتیک

تغییر مجوزها با استفاده از سیاست های IAM

افزایش اندازه حجم EBS

باز کردن پورتها برای Cloud9 Instance

آزمایشگاه Jupyter را در Cloud9 Instance راه اندازی کنید

درگاه SSH را برای نمونه Cloud9 EC2 باز کنید

با استفاده از SSH به نمونه Cloud9 EC2 متصل شوید

AWS شروع به کار با s3، AWS و CLI:

[دستورالعمل ها] مقدمه - AWS Getting Started

سطل s3 را ایجاد کنید

[دستورالعمل ها] سطل s3 را ایجاد کنید

گروه و کاربر IAM را ایجاد کنید

[دستورالعمل ها] گروه و کاربر IAM را ایجاد کنید

نمای کلی نقش ها

[دستورالعمل ها] مروری بر نقش ها

خط مشی سفارشی را ایجاد و پیوست کنید

[دستورالعمل ها و کد] خط مشی سفارشی را ایجاد و پیوست کنید

AWS CLI را پیکربندی و اعتبار سنجی کنید

[دستورالعمل ها و کد] AWS CLI را پیکربندی و اعتبار سنجی کنید

Storage - همه چیز درباره AWS s3 (سرویس ذخیره سازی ساده):

شروع به کار با AWS S3

[دستورالعمل ها] شروع به کار با AWS S3

تنظیم دادهها به صورت محلی برای آپلود در AWS s3

[دستورالعمل ها] تنظیم داده ها به صورت محلی برای آپلود در AWS s3

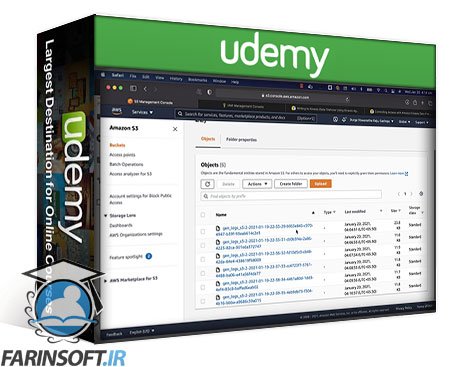

افزودن سطل ها و اشیاء AWS S3

[دستورالعمل] افزودن سطل ها و اشیاء AWS s3

کنترل نسخه در AWS S3

[دستورالعمل ها] کنترل نسخه در AWS S3

AWS S3 Cross-Region Replication برای تحمل خطا

[دستورالعمل ها] AWS S3 Cross-Region Replication برای تحمل خطا

نمای کلی کلاسهای ذخیرهسازی AWS S3 یا سطوح ذخیرهسازی

[دستورالعملها] مروری بر کلاسهای ذخیرهسازی AWS S3 یا سطوح ذخیرهسازی

نمای کلی Glacier در AWS s3

[دستورالعمل ها] نمای کلی از Glacier در AWS s3

مدیریت سطل ها و اشیاء AWS S3 با استفاده از AWS CLI

[دستورالعمل ها و دستورات] مدیریت سطل ها و اشیاء AWS S3 با استفاده از AWS CLI

مدیریت اشیا در AWS S3 با استفاده از AWS CLI - Lab

[دستورالعمل ها] مدیریت اشیاء در AWS S3 با استفاده از AWS CLI - Lab

امنیت AWS با استفاده از IAM - مدیریت کاربران، نقشها و خطمشیهای AWS با استفاده از AWS IAM:

ایجاد کاربران IAM

[دستورالعمل ها] ایجاد کاربران IAM

ورود به کنسول مدیریت AWS با استفاده از IAM User

[دستورالعمل ها] ورود به کنسول مدیریت AWS با استفاده از IAM User

دسترسی برنامهای به کاربر IAM را تأیید کنید

[دستورالعملها و دستورات] اعتبار دسترسی برنامهای به کاربر IAM را تأیید کنید

سیاست های مبتنی بر هویت IAM

[دستورالعملها و دستورات] سیاستهای مبتنی بر هویت IAM

مدیریت گروه های IAM

[دستورالعمل ها و دستورات] مدیریت گروه های IAM

مدیریت نقش های IAM

[دستورالعمل ها و دستورات] مدیریت نقش های IAM

مروری بر سیاست های سفارشی

[دستورالعملها و دستورات] مروری بر سیاستهای سفارشی

مدیریت IAM با استفاده از AWS CLI

[دستورالعمل ها و دستورات] مدیریت IAM با استفاده از AWS CLI

زیرساخت - مبانی AWS EC2 (Elastic Cloud Compute) :

شروع به کار با EC2

[دستورالعمل ها] شروع به کار با EC2

جفت کلید EC2 ایجاد کنید

[دستورالعملها] جفت کلید EC2 ایجاد کنید

نمونه EC2 را راه اندازی کنید

[دستورالعمل ها] نمونه EC2 را راه اندازی کنید

اتصال به نمونه EC2

[دستورالعمل ها و دستورات] اتصال به نمونه EC2

مبانی گروه های امنیتی

[دستورالعملها و دستورات] مبانی گروههای امنیتی

آدرس های IP عمومی و خصوصی

[دستورالعملها] آدرسهای IP عمومی و خصوصی

چرخه زندگی EC2

[دستورالعمل ها] چرخه زندگی EC2

تخصیص و تخصیص آدرس IP الاستیکess

[دستورالعمل ها] تخصیص و تخصیص آدرس های IP الاستیک

مدیریت EC2 با استفاده از AWS CLI

[دستورالعمل ها و دستورات] مدیریت EC2 با استفاده از AWS CLI

نمونه های EC2 را ارتقا یا کاهش دهید

[دستورالعملها و دستورات] نمونههای EC2 را ارتقا یا کاهش دهید

زیرساخت - AWS EC2 Advanced:

شناخت فراداده EC2

[دستورالعمل ها و دستورات] درک فراداده EC2

پرسش در فراداده EC2

[دستورالعملها و دستورات] پرسوجو در فراداده EC2

Fitering on EC2 Metadata

[دستورالعملها و دستورات] فیلتر کردن بر روی فراداده EC2

استفاده از اسکریپت های بوت استرپینگ

[دستورالعمل ها و دستورات] با استفاده از اسکریپت های بوت استرپینگ

یک AMI ایجاد کنید

[دستورالعمل ها و دستورات] یک AMI ایجاد کنید

تأیید AMI - Lab

[دستورالعملها و دستورات] اعتبارسنجی AMI - Lab

بلع داده با استفاده از توابع لامبدا:

Hello World با استفاده از AWS Lambda

[دستورالعمل ها] Hello World با استفاده از AWS Lambda

پروژه راه اندازی برای توسعه محلی

[دستورالعمل ها و کد] پروژه راه اندازی برای توسعه محلی

استقرار پروژه در کنسول AWS Lambda

[دستورالعمل ها و کد] پروژه را در کنسول AWS Lambda اجرا کنید

قابلیت دانلود را با استفاده از درخواست ها توسعه دهید

[دستورالعملها و کد] قابلیت دانلود را با استفاده از درخواستها توسعه دهید

استفاده از کتابخانه های شخص ثالث در AWS Lambda

[دستورالعمل ها و کد] با استفاده از کتابخانه های شخص ثالث در AWS Lambda

اعتبار سنجی دسترسی s3 برای توسعه محلی

[دستورالعمل ها و کد] اعتبار سنجی دسترسی s3 برای توسعه محلی

قابلیت آپلود را در s3 توسعه دهید

[دستورالعمل ها و کد] قابلیت آپلود را در s3 توسعه دهید

اعتبار سنجی با استفاده از کنسول AWS Lambda

[دستورالعمل ها و کد] اعتبارسنجی با استفاده از کنسول AWS Lambda

با استفاده از کنسول AWS Lambda اجرا شود

[دستورالعمل ها] با استفاده از کنسول AWS Lambda اجرا شود

اعتبار سنجی فایل ها به صورت تدریجی

[دستورالعمل ها و کد] اعتبار سنجی فایل ها به صورت تدریجی

خواندن و نوشتن نشانک با استفاده از s3

[دستورالعمل ها و کد] خواندن و نوشتن نشانک با استفاده از s3

نگهداری نشانک با استفاده از s3

[دستورالعمل ها و کد] نگهداری نشانک با استفاده از s3

منطق آپلود افزایشی را مرور کنید

استقرار تابع لامبدا

[دستورالعمل ها و کد منبع] - ghactivity-downloader تابع Lambda

عملکرد Lambda را با استفاده از AWS Event Bridge برنامه ریزی کنید

[دستورالعمل ها] با استفاده از پل رویداد AWS، عملکرد لامبدا را برنامه ریزی کنید

چرخه عمر توسعه برای Pyspark:

محیط مجازی را راه اندازی کرده و Pyspark را نصب کنید

[Commands] - محیط مجازی را راه اندازی کرده و Pyspark را نصب کنید

شروع با Pycharm

[کد و دستورالعمل] - شروع به کار با Pycharm

گذراندن آرگومان های زمان اجرا

دسترسی به متغیرهای محیط سیستم عامل

شروع با Spark

ایجاد تابع برای Spark Session

[Code and Instructions] - ایجاد تابع برای Spark Session

تنظیم داده های نمونه

دادهها را از فایلها بخوانید

[کد و دستورالعمل ها] - خواندن داده ها از فایل ها

پردازش داده ها با استفاده از Spark API

[Code and Instructions] - پردازش داده ها با استفاده از Spark API

داده ها را در فایل ها بنویسید

[کد و دستورالعمل ها] - داده ها را در فایل ها بنویسید

اعتبار سنجی نوشتن داده ها در فایل ها

تولید کد

[کد و دستورالعمل] - تولید کد

نمای کلی اجزای چسب:

مقدمه - مروری بر اجزای چسب

[دستورالعمل ها] مروری بر اجزای چسب

خزنده و جدول کاتالوگ ایجاد کنید

[دستورالعمل ها] جدول خزنده و کاتالوگ را ایجاد کنید

تجزیه و تحلیل داده ها با استفاده از آتنا

[دستورالعمل ها] تجزیه و تحلیل داده ها با استفاده از Athena

ایجاد سطل و نقش S3

[دستورالعمل ها و کد] ایجاد سطل و نقش S3

کار چسب را ایجاد و اجرا کنید

[دستورالعمل ها] کار چسب را ایجاد و اجرا کنید

اعتبار سنجی با استفاده از Glue CatalogTable و Athena

[دستورالعملها و کد] با استفاده از Glue CatalogTable و Athena اعتبارسنجی کنید

ماشه چسب را ایجاد و اجرا کنید

[دستورالعمل ها و کد] ماشه چسب را ایجاد و اجرا کنید

گردش کار چسب را ایجاد کنید

[دستورالعملها] گردش کار چسب را ایجاد کنید

روی کاری چسب را اجرا و اعتبارسنجی کنید

[دستورالعمل ها] Glue Workflow را اجرا و اعتبارسنجی کنید

راه اندازی سرور Spark History برای Glue Jobs:

مقدمه - Spark History Server for Glue

سرور Spark History را در AWS راه اندازی کنید

مخزن نمونه چسب AWS را کلون کنید

[دستورالعمل ها و کد] مخزن نمونه چسب AWS کلون

کانتینر رابط کاربری Glue Spark

[دستورالعمل ها و کد] کانتینر رابط کاربری چسب اسپارک

مجوزهای خط مشی IAM را به روز کنید

Start Glue Spark UI Container

[دستورالعملها و کد] محفظه رابط کاربری چسب Spark

غواصی عمیق در کاتالوگ چسب:

پیش نیاز جداول کاتالوگ چسب

[دستورالعمل ها] پیش نیازهای جداول کاتالوگ چسب

مراحل ایجاد جداول کاتالوگ

[دستورالعمل ها] مراحل ایجاد جداول کاتالوگ

دانلود مجموعه داده

[دستورالعمل ها و کد] مجموعه داده را دانلود کنید

آپلود داده ها در s3

[دستورالعملها و کد] دادهها را آپلود کنیدs3

ایجاد پایگاه داده کاتالوگ چسب - itvghlandingdb

[دستورالعمل ها] ایجاد پایگاه داده کاتالوگ چسب - itvghlandingdb

ایجاد جدول کاتالوگ چسب - ghactivity

[دستورالعمل ها] جدول کاتالوگ چسب ایجاد کنید - ghactivity

اجرای کوئری ها با استفاده از Athena - ghactivity

[دستورالعمل ها و کد] اجرای پرس و جوها با استفاده از Athena - ghactivity

خزیدن چندین پوشه

[دستورالعمل ها] خزیدن پوشه های متعدد

مدیریت کاتالوگ چسب با استفاده از AWS CLI

[دستورالعمل ها و کد] مدیریت کاتالوگ چسب با استفاده از AWS CLI

مدیریت کاتالوگ چسب با استفاده از Python Boto3

[دستورالعمل ها و کد] مدیریت کاتالوگ چسب با استفاده از Python Boto3

کاوش APIهای Glue Job:

نقش IAM را برای Glue Job به روز کنید

[دستورالعمل ها و کد] نقش IAM را برای کار چسب به روز کنید

ایجاد کار چسب پایه

[دستورالعملها و کد] کار چسب پایه را ایجاد کنید

اجرای پایه چسب

[دستورالعملها] کار چسب پایه در حال اجرا

چسب اسکریپت برای پارتیشن بندی داده ها

[دستورالعمل ها و کد] اسکریپت چسب برای پارتیشن بندی داده ها

اعتبار سنجی با استفاده از آتنا

[دستورالعملها و کد] اعتبارسنجی با استفاده از آتنا

نشانکهای کار چسب:

مقدمه ای بر بومارک های کار چسب

پاک کردن داده ها

[دستورالعمل ها و کد] پاک کردن داده ها

نمای کلی AWS Glue CLI

[دستورالعمل ها و کد] نمای کلی AWS Glue CLI

کار را با استفاده از نشانک اجرا کنید

[دستورالعمل ها و کد] کار را با استفاده از نشانک اجرا کنید

اعتبارسنجی نشانک با استفاده از AWS CLI

[دستورالعمل ها و کد] نشانک را با استفاده از AWS CLI اعتبار سنجی کنید

داده های جدید را به فرود اضافه کنید

[دستورالعملها و کد] دادههای جدید را به فرود اضافه کنید

کار چسب را با استفاده از نشانک اجرا کنید

[دستورالعمل ها و کد] کار چسب را با استفاده از نشانک اجرا کنید

نشانک کار و فایلها را برای اجرای افزایشی اعتبارسنجی کنید

[دستورالعملها و کد] نشانکهای شغلی و فایلها را برای اجرای افزایشی اعتبارسنجی کنید

جدول کاتالوگ چسب را با استفاده از CLI دوباره بخزید

[دستورالعملها و کد] با استفاده از CLI، جدول کاتالوگ سرنخ را دوباره بخزید

پرس و جوهای Athena را برای اعتبارسنجی داده ها اجرا کنید

[دستورالعملها و کد] Queries Athena را برای اعتبارسنجی دادهها اجرا کنید

شروع با AWS EMR:

برنامه ریزی خوشه EMR

جفت کلید EC2 ایجاد کنید

راه اندازی خوشه EMR با Spark

درک خلاصه AWS EMR Cluster

رابط های کاربری برنامه EMR Cluster را بررسی کنید

بررسی EMR Cluster Monitoring07 بررسی EMR Cluster Monitoring

خطمشی سختافزار خوشهای EMR و مقیاسبندی خوشه را مرور کنید

تنظیمات خوشه EMR را مرور کنید

رویدادهای EMR Cluster را مرور کنید

مرحلههای EMR Cluster را مرور کنید

اقدامات بوت استرپ EMR Cluster را مرور کنید

اتصال به EMR Master Node با استفاده از SSH

غیرفعال کردن حفاظت خاتمه و خاتمه خوشه

کلون و ایجاد خوشه جدید

فهرست کردن سطل ها و اشیاء AWS S3 با استفاده از AWS CLI در خوشه EMR

فهرست کردن سطل ها و اشیاء AWS S3 با استفاده از HDFS CLI در خوشه EMR

مدیریت فایل ها در AWS s3 با استفاده از HDFS CLI در EMR Cluster

استقرار برنامههای Spark با استفاده از AWS EMR:

استقرار برنامه ها با استفاده از AWS EMR - مقدمه

EMR Cluster را برای استقرار برنامه ها راه اندازی کنید

اعتبار اتصال SSH به گره اصلی خوشه AWS EMR

محیط نوت بوک Jupyter را در خوشه EMR تنظیم کنید

سطل AWS s3 مورد نیاز را ایجاد کنید

داده های GHActivity را در s3 آپلود کنید

اعتبار برنامه را با استفاده از نسخه های سازگار AWS EMR تأیید کنید

استقرار برنامه در AWS EMR Master Node

فضای کاربری برای ec2-user در AWS EMR Cluster ایجاد کنید

اجرای Spark Application با استفاده از spark-submit در AWS EMR Master Node

اعتبارسنجی داده ها با استفاده از نوت بوک های Jupyter در AWS EMR Cluster

کلون کردن و شروع خودکار پایان یافته AWS EMR Cluster

حذف داده های پر شده توسط برنامه GHAcitivity با استفاده از خوشه AWS EMR

تفاوتهای بین Spark Client و Cluster Deployment Modes

اجرای برنامه Spark با استفاده از حالت کلاستر در AWS EMR Cluster

نمای کلی افزودن برنامه Pyspark به عنوان مرحله به خوشه AWS EMR

استقرار Spark Application در AWS S3

اجرای برنامه های Spark به عنوان مراحل AWS EMR در حالت مشتری

اجرای برنامه های Spark به عنوان مراحل AWS EMR در حالت خوشه ای

اعتبار AWS EMR Step Execution of Spark Application

خط لوله جریان با استفاده از Kinesis:

ساخت خط لوله جریان با استفاده از Kinesis

سیاهههای مربوط به چرخش

راه اندازی Kinesis Firehose Agent

جریان تحویل Kinesis Firehose را ایجاد کنید

برنامه ریزی خط لوله

گروه و کاربر IAM را ایجاد کنید

اعطای مجوزها به کاربر IAM با استفاده از خط مشی

Kinesis Firehose Agent را پیکربندی کنید

عامل شروع و اعتبار سنجی

نتیجه گیری - ساخت خط لوله بخار ساده

مصرف داده از s3 با استفاده از boto3:

سفارشی کردن پوشه s3 با استفاده از Kinesis Delivery Stream

خط مشی برای خواندن از سطل s3 ایجاد کنید

دسترسی s3 را با استفاده از AWS CLI تأیید کنید

محیط مجازی پایتون را برای کاوش boto3 راه اندازی کنید

اعتبار سنجی دسترسی به s3 با استفاده از Python boto3

مطالب را از شی s3 بخوانید

خواندن چندین شی s3

با استفاده از نشانگر، تعداد s3 Object را دریافت کنید

اندازه اشیاء s3 را با استفاده از نشانگر دریافت کنید

پر کردن دادههای GitHub در Dynamodb:

کتابخانه های مورد نیاز را نصب کنید

آشنایی با APIهای GitHub

تنظیم توکن GitHub API

درک محدودیت نرخ GitHub

ایجاد مخزن جدید برای since

استخراج اطلاعات مورد نیاز

پردازش داده ها

برای ایجاد جداول dynamodb با استفاده از boto3 مجوز اعطا کنید

جداول Dynamodb را ایجاد کنید

عملیات Dynamodb CRUD

جدول Dynamodb را پر کنید

عملیات دسته ای Dynamodb

نمای اجمالی آمازون آتنا:

شروع با آمازون آتنا

بازنویسی سریع پایگاه های داده و جداول کاتالوگ چسب

با استفاده از ویرایشگر Athena Query به پایگاههای داده و جداول کاتالوگ چسب دسترسی پیدا کنید

ایجاد پایگاه داده و جدول با استفاده از آتنا

داده ها را با استفاده از Athena در جدول پر کنید

استفاده از CTAS برای ایجاد جداول با استفاده از Athena

مروری بر معماری آمازون آتنا

منابع آمازون آتنا و رابطه با Hive

جدول پارتیشن بندی شده را با استفاده از آتنا ایجاد کنید

Query را برای ستون پارتیشن بندی شده توسعه دهید

با استفاده از Athena در جداول پارتیشن بندی شده قرار دهید

تأیید پارتیشن بندی داده ها با استفاده از آتنا

جداول آتنا را رها کنید و فایل های داده را حذف کنید

جدول پارتیشن بندی شده را با استفاده از آتنا رها کنید

پارتیشن بندی داده ها در آتنا با استفاده از CTAS

Amazon Athena با استفاده از AWS CLI:

آمازون آتنا با استفاده از AWS CLI - مقدمه

کمک بگیرید و پایگاه داده های Athena را با استفاده از AWS CLI فهرست کنید

[فرمانها] کمک بگیرید و پایگاههای داده Athena را با استفاده از AWS CLI فهرست کنید

مدیریت گروههای کاری آتنا با استفاده از AWS CLI

[فرمانها] مدیریت گروههای کاری Athena با استفاده از AWS CLI

پرس و جوهای Athena را با استفاده از AWS CLI اجرا کنید

[فرمانها] کوئریهای Athena را با استفاده از AWS CLI اجرا کنید

متادیتا جدول آتنا را با استفاده از AWS CLI دریافت کنید

[فرمانها] متادیتای جدول Athena را با استفاده از AWS CLI دریافت کنید

Athena Queries را با مکان سفارشی با استفاده از AWS CLI اجرا کنید

[فرمانها] کوئریهای Athena را با مکان سفارشی اجرا کنید

جدول Athena را با استفاده از AWS CLI رها کنید

[فرمانها] جدول Athena را با استفاده از AWS CLI رها کنید

CTAS را تحت Athena با استفاده از AWS CLI اجرا کنید

[فرمانها] CTAS را تحت Athena با استفاده از AWS CLI اجرا کنید

Amazon Athena با استفاده از Python boto3:

Amazon Athena با استفاده از Python boto3 - مقدمه

شروع به مدیریت آتنا با استفاده از Python boto3

[کد] شروع به مدیریت آتنا با استفاده از Python boto3

پایگاه های داده آمازون آتنا را با استفاده از Python boto3 فهرست کنید

[کد] پایگاههای داده آمازون آتنا را با استفاده از Python boto3 فهرست کنید

جدولهای Amazon Athena را با استفاده از Python boto3 فهرست کنید

[کد] جدولهای Amazon Athena را با استفاده از Python boto3 فهرست کنید

Amazon Athena Queries را با استفاده از Python boto3 اجرا کنید

[کد] پرس و جوهای Amazon Athena را با استفاده از Python boto3 اجرا کنید

نتایج جستجوی Athena را با استفاده از boto3 مرور کنید

[کد] نتایج جستجوی Athena را با استفاده از Python boto3 مرور کنید

شروع با Amazon Redshift:

شروع با Amazon Redshift - مقدمه

خوشه Redshift را با استفاده از نسخه آزمایشی رایگان ایجاد کنید

اتصال به پایگاه داده با استفاده از Redshift Query Editor

دریافت لیست جداول پرس و جو از طرح اطلاعات

[Queries] - فهرست جداول پرس و جوی طرح اطلاعات را دریافت کنید

پرس و جوها را در مقابل جداول Redshift با استفاده از ویرایشگر کوئری اجرا کنید

[Queries] - با استفاده از Query Editor دادههای کاربران را اعتبارسنجی کنید

جدول Redshift را با استفاده از کلید اصلی ایجاد کنید

[Queries] - جدول Redshift ایجاد کنید

[پرس و جوهای تلفیقی] - عملیات CRUD

درج داده ها در جداول Redshift

بهروزرسانی دادهها در جداول Redshift

حذف داده ها از جداول Redshift

جستجوهای ذخیره شده را با استفاده از ویرایشگر پرس و جو به Redshift کنید

حذف Redshift Cluster

Redshift Cluster را از Snapshot بازیابی کنید

کپی داده ها از s3 در Redshift Tables:

کپی داده ها از s3 به Redshift - مقدمه

داده ها را در s3 برای Redshift Copy تنظیم کنید

کپی پایگاه داده و جدول برای Redshift Copy Command

کاربر IAM را با دسترسی کامل در s3 برای Redshift Copy ایجاد کنید

برای کپی داده ها از s3 به Reshift Table، Command Copy را اجرا کنید

عیبیابی خطاهای مربوط به Redshift Copy Command

برای کپی کردن از جدول s3 به Redshift، دستور Copy را اجرا کنید

اعتبار سنجی با استفاده از پرس و جو در مقابل جدول Redshift

نمای کلی از Redshift Copy Command

برای دسترسی به s3، نقش IAM را برای Redshift ایجاد کنید

داده ها را از s3 به جدول Redshift با استفاده از IAM Role کپی کنید

تنظیم JSON Dataset در s3 برای Redshift Copy Command

دادههای JSON را از s3 به جدول Redshift با استفاده از IAM Role کپی کنید

برنامهها را با استفاده از Redshift Cluster توسعه دهید:

توسعه برنامه با استفاده از Redshift Cluster - مقدمه

Ip الاستیک را برای Redshift Cluster اختصاص دهید

دسترسی عمومی را برای Redshift Cluster فعال کنید

قوانین ورودی را در Security Group به روز کنید تا به Redshift Cluster دسترسی پیدا کنید

ایجاد پایگاه داده و کاربر در Redshift Cluster

با استفاده از psql به پایگاه داده در Redshift متصل شوید

تغییر مالک در جداول Redshift

فایل Redshift JDBC Jar را دانلود کنید

با استفاده از IDE هایی مانند SQL Workbench به پایگاه های داده Redshift متصل شوید

محیط مجازی پایتون را برای Redshift تنظیم کنید

Simple Query را در مقابل جدول پایگاه داده Redshift با استفاده از پایتون اجرا کنید

جدول Redshift را با استفاده از P کوتاه کنیدython

کاربر IAM را برای کپی کردن از s3 به Redshift جداول ایجاد کنید

اعتبار دسترسی کاربر IAM را با استفاده از Boto3 تأیید کنید

دستور کپی Redshift را با استفاده از پایتون اجرا کنید

جداول جابجایی قرمز با کلیدهای Distkey و Sortkeys:

جداول Redshift با Distkeys و Sortkeys - مقدمه

بررسی سریع معماری Redshift

خوشه Redshift چند گره ای ایجاد کنید

با استفاده از Query Editor به Redshift Cluster متصل شوید

پایگاه داده Redshift ایجاد کنید

کاربر پایگاه داده Redshift ایجاد کنید

ایجاد طرحواره پایگاه داده Redshift

سبک توزیع پیشفرض جدول Redshift

اعطای مجوزهای انتخاب در کاتالوگ به کاربر پایگاه داده Redshift

مسیر جستجو را برای درخواست جداول سیستم Redshift به روز کنید

تأیید اعتبار جدول با DISTSTYLE AUTO

Cluster را از Snapshot به حالت اولیه ایجاد کنید

نمای کلی Node Slices در Redshift Cluster

مروری بر سبک های توزیع

استراتژی های توزیع برای جداول خرده فروشی در Redshift

جدول Redshift را با سبک توزیع همه ایجاد کنید

عیبیابی و رفع خطاهای بارگیری یا کپی کردن

جدول Redshift را با خودکار سبک توزیع ایجاد کنید

جداول Redshift را با استفاده از کلید سبک توزیع ایجاد کنید

حذف خوشه با عکس فوری دستی

پرسشها و طیف فدرال Redshift:

پرس و جوها و طیف فدرال Redshift - مقدمه

مروری بر ادغام RDS و Redshift برای جستجوهای فدرال

نقش IAM را برای Redshift Cluster ایجاد کنید

سرور پایگاه داده Postgres را برای پرس و جوهای فدرال Redshift راه اندازی کنید

جداول را در پایگاه داده Postgres برای Queries فدرال Redshift ایجاد کنید

ایجاد راز با استفاده از Secrets Manager برای پایگاه داده Postgres

دسترسی به جزئیات مخفی با استفاده از Python Boto3

خواندن دادههای Json در Dataframe با استفاده از پاندا

داده های JSON را با استفاده از پانداها در جداول پایگاه داده بنویسید

خط مشی IAM را برای Secret ایجاد کنید و با Redshift Role ارتباط برقرار کنید

خوشه Redshift را با استفاده از نقش IAM با مجوزهای مخفی ایجاد کنید

طرحواره خارجی Redshift را در پایگاه داده Postgres ایجاد کنید

تنظیمات شبکه Redshift Cluster را برای جستارهای فدرال بهروزرسانی کنید

اجرای ETL با استفاده از Redshift Federated Queries

پاک کردن منابع اضافه شده برای Redshift Federated Queries

اعطای دسترسی به کاتالوگ داده های چسب به Redshift Cluster for Spectrum

خوشه های Redshift را برای اجرای پرس و جوها با استفاده از Spectrum راه اندازی کنید

بازنویسی سریع پایگاه داده و جداول کاتالوگ چسب برای طیف Redshift

طرحواره خارجی را با استفاده از Redshift Spectrum ایجاد کنید

پرس و جوها را با استفاده از Redshift Spectrum اجرا کنید

خوشه Redshift را پاک کنید

Data Engineering Master Class using AWS Analytics Services

در این روش نیاز به افزودن محصول به سبد خرید و تکمیل اطلاعات نیست و شما پس از وارد کردن ایمیل خود و طی کردن مراحل پرداخت لینک های دریافت محصولات را در ایمیل خود دریافت خواهید کرد.

Mastering Databricks SQL Warehouse and Spark SQL

مهندسی داده ها با استفاده از Databricks در AWS و Azure

آموزش کدنویسی Apache Spark 2022 و Databricks در آن

Master Data Engineering using GCP Data Analytics

-main-resized.jpg)

کورس کدنویسی Spark SQL and PySpark 3 در زبان پایتون

مسلط شدن بر Amazon Redshift و مبحث Serverless

فیلم یادگیری کامل Spark SQL, Spark 3 و استفاده از Scala

مهندسی دیتا : کار با SQL, Python and Spark

Master Data Engineering using Azure Data Analytics