در حال حاضر محصولی در سبد خرید شما وجود ندارد.

یادگیری مهارت های مهندسی داده های کلیدی مانند SQL، پایتون و Pyspark با تن از وظایف دست و تمرینات با استفاده از آزمایشگاه ها.

عنوان اصلی : Data Engineering Essentials Hands-on - SQL, Python and Spark

سرفصل های دوره :

معرفی دوره :

نمای کلی محیط برای تمرین

تنظیم محیط برای یادگیری Python، SQL، Hadoop، Spark با استفاده از Docker در ویندوز 11:

تنظیم محیط با استفاده از Docker در ویندوز 11 - مقدمه

آشنایی با پیکربندی سیستم رایانه شخصی ویندوز 11

مراحل راه اندازی Docker Desktop در ویندوز 11

WSL2 را در ویندوز 11 با نصب Ubuntu VM با استفاده از WSL فعال کنید

بسته بهروزرسانی هسته لینوکس را در ویندوز 11 برای Docker Desktop نصب کنید

Docker Desktop را در ویندوز 11 دانلود و نصب کنید

اعتبارسنجی git با استفاده از WSL Ubuntu در ویندوز 11

Clone Data Engineering Essentials Materials در ویندوز 11

کانتینرهای Python و SQL را با استفاده از دستور docker-compose در ویندوز 11 راه اندازی کنید

Pycharm را در ویندوز 11 دانلود و نصب کنید

راه اندازی پروژه Pycharm برای مهندسی داده

بررسی فایل Docker Compose برای مواد ضروری مهندسی داده

برای مدیریت خدمات، دستورات مهم Docker Compose را مرور کنید

برای یادگیری Python و SQL به محیط مبتنی بر Jupyter دسترسی پیدا کنید

دریافت رمز Jupyter Lab برای ورود به Jupyter Lab

تنظیم محیط برای یادگیری Python، SQL، Hadoop، Spark با استفاده از Docker در ویندوز 10:

آشنایی با پیکربندی سیستم

Docker Desktop را در ویندوز راه اندازی کنید

اعتبار Docker را در ویندوز با استفاده از Command Line با استفاده از Power Shell تأیید کنید

تنظیمات منبع دسکتاپ Docker را بررسی کنید

مخزن GitHub را در ویندوز کلون کنید

راه اندازی پروژه Pycharm برای ملزومات مهندسی داده

تنظیمات جهانی Git مربوط به پایان خط را به روز کنید

بررسی خدمات Docker Compose

Python و SQL Environment را با استفاده از Docker Compose شروع کنید

استفاده از منابع را پس از راه اندازی Python و SQL Environment مرور کنید

برای یادگیری پایتون به محیط مبتنی بر Jupyter دسترسی پیدا کنید

دریافت رمز Jupyter Lab برای ورود به Jupyter Lab

تنظیم محیط برای یادگیری Python، SQL، Hadoop و Spark با استفاده از Docker در مک:

تنظیم محیط با استفاده از Mac

راه اندازی Docker Desktop در Mac

تأیید تنظیم Docker در Mac

تنظیمات حافظه و CPU Docker Desktop را برای Mac مرور کنید

Docker Desktop را برای محیط ضروری مهندسی داده پیکربندی کنید

Clone GitHub Repository for Data Engineering Essentials

راه اندازی به عنوان Pycharm Project برای بررسی فایل ها با استفاده از IDE

بازبینی فایل Docker Compose برای Python و SQL Lab

Python و SQL Environment را با استفاده از Docker Compose شروع کنید

استفاده از منابع را پس از راه اندازی Python و SQL Environment مرور کنید

برای یادگیری پایتون به محیط مبتنی بر Jupyter دسترسی پیدا کنید

دریافت رمز Jupyter Lab برای ورود به Jupyter Lab

تنظیم محیط برای یادگیری Python، SQL و همچنین Spark با استفاده از AWS Cloud9:

شروع به کار با Cloud9

ایجاد محیط Cloud9

گرم کردن با Cloud9 IDE

جزئیات در مورد مواد برای راه اندازی پایگاه داده postgres با استفاده از docker

مروری بر EC2 مربوط به Cloud9

باز کردن پورتها برای Cloud9 Instance

ارتباط IP های الاستیک به نمونه Cloud9

اندازه صدای EBS نمونه Cloud9 را افزایش دهید

تنظیم Docker Compose در نمونه AWS Cloud9

مخزن GitHub را کلون کنید

پایتون و محیط SQL را با استفاده از Docker Compose راه اندازی کنید

قوانین ورودی گروه امنیتی AWS EC2 را بهروزرسانی کنید

وارد محیط مبتنی بر Jupyter شوید

مفاهیم شبکه برای مبتدیان - آدرس های IP و شماره پورت:

تلنت را در ویندوز فعال کنید

انواع آدرس IP مختلف

شمارههای پورت مرتبط با برنامهها یا خدمات

برگرداندن پورت SSH به شماره درگاه پیشفرض

Apache2 را در اوبونتو راه اندازی کنید

مروری بر لوکال هاست

نمای کلی از آدرس IP خصوصی مرتبط با یک سرور

نمای کلی آدرس IP عمومی مرتبط با یک سرور

راه اندازی برنامه وب و دسترسی با استفاده از IP محلی

راه اندازی برنامه وب و دسترسی با استفاده از IP خصوصی

دسترسی به برنامه وب را با استفاده از IP عمومی غیرفعال کنید

sshuttle را با استفاده از brew در مک نصب کنید

با استفاده از IP خصوصی با استفاده از SSH به عنوان پروکسی به برنامه وب دسترسی پیدا کنید

ضرورت های پایگاه داده - شروع به کار:

پایگاه داده پیامک را با استفاده از Postgres تنظیم کنید

اتصال به پایگاه داده Postgresql

استفاده از psql برای تعامل با پایگاه داده Postgresql با استفاده از CLI

ابزارهای بارگیری داده در Postgresql

ضرورت های پایگاه داده - عملیات پایگاه داده:

عملیات پایگاه داده - نمای کلی

عملیات CRUD پایگاه داده

ایجاد جدول در پایگاه داده Postgres

درج داده ها در جدول پایگاه داده Postgres

به روز رسانی داده ها در جدول پایگاه داده Postgres

حذف داده ها در جدول پایگاه داده Postgres

مروری بر معاملات پایگاه داده

تمرین - عملیات DML یا CRUD با استفاده از Postgresql

ضرورت های پایگاه داده - نوشتن پرس و جوهای اولیه SQL:

تحولات استاندارد

نمای کلی مدل داده

بیان مشکل را تعریف کنید

تهیه جداول پایگاه داده با استفاده از Postgres

انتخاب یا طرح داده ها از جداول پایگاه داده Postgres با استفاده از SQL

فیلتر کردن داده ها از جداول پایگاه داده Postgres با استفاده از SQL

پیوستن به جداول پایگاه داده Postgres با استفاده از SQL - Inner

پیوستن به جداول پایگاه داده Postgres با استفاده از SQL - Outer

اجرای تجمیع با استفاده از SQL در جداول پایگاه داده Postgres

مرتبسازی دادهها در جداول Postgres با استفاده از SQL

راه حل - درآمد روزانه محصول با استفاده از SQL در جداول پایگاه داده Postgres

تمرینات - نوشتن پرس و جوهای اولیه SQL در جداول پایگاه داده Postgres

ضرورت های پایگاه داده - ایجاد جداول و نمایه ها:

DDL - زبان تعریف داده

مروری بر انواع داده های مورد استفاده در هنگام ایجاد جداول پایگاه داده Postgres

افزودن یا اصلاح ستون ها با استفاده از Alter در جداول پایگاه داده Postgres

انواع مختلفی از محدودیت های مورد استفاده در جداول پایگاه داده

مدیریت محدودیت ها در جداول پایگاه داده Postgres

شاخصها در جداول پایگاه داده Postgres

شاخص های محدودیت در جداول پایگاه داده Postgres

مروری بر توالی های مورد استفاده در جداول پایگاه داده Postgres

قطع کردن جداول پایگاه داده Postgres

حذف جداول پایگاه داده Postgres

تمرین ها و راه حل ها - مدیریت اشیاء پایگاه داده با استفاده از Postgresql

ضرورت های پایگاه داده - جداول و نمایه های پارتیشن بندی:

مروری بر پارتیشن بندی جداول پایگاه داده Postgres

لیست پارتیشن بندی جداول پایگاه داده

مدیریت پارتیشن های جداول پایگاه داده Postgres - لیست

دستکاری داده ها در جداول پارتیشن بندی شده پایگاه داده Postgres

تقسیم بندی محدوده جداول پایگاه داده Postgres

مدیریت پارتیشن های جداول پایگاه داده Postgres - Range

پارتیشن بندی مجدد جداول پایگاه داده Postgres - محدوده

پارتیشن بندی هش جداول پایگاه داده Postgres

مدیریت پارتیشن های جداول پایگاه داده Postgres - Hash

سناریوهای استفاده از جداول پارتیشن بندی شده پایگاه داده

تقسیم بندی جداول پایگاه داده Postgres

تمرین - جداول تقسیم بندی شده جداول پایگاه داده Postgres

ضرورت های پایگاه داده - توابع از پیش تعریف شده:

نمای کلی توابع SQL در Postgres

توابع دستکاری رشته در SQL با استفاده از Postgres

Case Conversion و Length با استفاده از توابع در SQL با استفاده از Postgres

استخراج داده - استفاده از توابع substr و split_part در SQL با استفاده از Postgres

استفاده از توابع موقعیت یا strpos در SQL با استفاده از Postgres

توابع برش و بالشتک در SQL با استفاده از Postgres

معکوس و الحاق چند رشته با استفاده از توابع در SQL با استفاده از Postgres

تعویض رشته با استفاده از توابع در SQL با استفاده از Postgres

توابع دستکاری تاریخ با استفاده از SQL در Postgres

دریافت تاریخ یا مهر زمانی فعلی با استفاده از توابع در SQL با استفاده از Postgres

محاسبه تاریخ با استفاده از توابع در SQL با استفاده از Postgres

تاریخ یا زمان شروع با استفاده از تابع date_trunc در SQL با استفاده از Postgres

استفاده از توابع to_char و to_date در SQL با استفاده از Postgres

استخراج اطلاعات با استفاده از تابع استخراج در SQL با استفاده از Postgres

برخورد با Unix Timestamp یا Epoch با استفاده از توابع در SQL با استفاده از Postgres

مروری بر توابع عددی با استفاده از SQL در Postgres

تبدیل نوع داده با استفاده از توابع در SQL با استفاده از Postgres

مدیریت مقادیر NULL با استفاده از SQL در Postgres

استفاده از CASE و WHEN به عنوان بخشی از SQL در Postgres

ضرورت های پایگاه داده - نوشتن پرس و جوهای پیشرفته SQL:

نمای کلی نماهای پایگاه داده با استفاده از پایگاه داده Postgres

مروری بر پرس و جوهای نامگذاری شده با استفاده از SQL در Postgres

مروری بر پرس و جوهای فرعی با استفاده از SQL در Postgres

CTAS - ایجاد جدول به عنوان انتخاب با استفاده از Postgres

عملیات پیشرفته DML در جداول پایگاه داده Postgres

ادغام یا اضافه کردن داده ها در جداول پایگاه داده Postgres

چرخش ردیف ها به ستون ها با استفاده از SQL در Postgres

مروری بر توابع تحلیلی با استفاده از SQL در Postgres

توابع تحلیلی - تجمیع با استفاده از SQL در Postgres

تجمعات تجمعی یا متحرک با استفاده از SQL در Postgres

توابع تحلیلی با استفاده از SQL در Postgres - Windowing

توابع تحلیلی با استفاده از SQL در Postgres - رتبه بندی

توابع تحلیلی با استفاده از SQL در Postgres - Filtering

رتبه بندی و فیلتر کردن با استفاده از SQL در Postgres - Recap

تمرین - نوشتن پرس و جوهای پیشرفته

ضرورت های برنامه نویسی با استفاده از پایتون - انجام عملیات پایگاه داده:

مقدمه - انجام عملیات پایگاه داده

نمای کلی SQL

ایجاد پایگاه داده و جدول کاربران

DDL - زبان تعریف داده

DML - زبان دستکاری داده ها

DQL - زبان جستجوی داده

عملیات CRUD - DML و DQL

TCL - زبان کنترل تراکنش

مثال - مهندسی داده

مثال - برنامه وب

تمرین - عملیات پایگاه داده

مبانی برنامه نویسی با استفاده از پایتون - شروع به کار با پایتون:

نصب پایتون در ویندوز

نمای کلی آناکوندا

Python CLI و Jupyter Notebook

مروری بر آزمایشگاه Jupyter

استفاده از IDE - Pycharm

استفاده از کد ویژوال استودیو

استفاده از ITVersity Labs

استفاده از Google Colab

ضرورت های برنامه نویسی با استفاده از پایتون - ساختارهای برنامه نویسی پایه:

ساختارهای اصلی برنامه نویسی با استفاده از پایتون - مقدمه

دریافت راهنما با استفاده از تابع help در پایتون

متغیرها و اشیاء پایتون

انواع داده پایتون - معمولاً استفاده می شود

عملگرها در پایتون

وظایف - انواع داده و عملگرها با استفاده از پایتون

توسعه شرط ها با استفاده از پایتون

همه چیز درباره حلقه های for در پایتون

اجرای دستورات سیستم عامل در پایتون

تمرینات - ساختارهای برنامه نویسی پایه با استفاده از پایتون

عملیات محاسباتی پویا با استفاده از eval و exec در پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - توابع از پیش تعریف شده:

توابع از پیش تعریف شده در پایتون - مقدمه

نمای کلی توابع از پیش تعریف شده در پایتون

توابع عددی در پایتون

نمای کلی رشته ها در پایتون

توابع دستکاری رشته در پایتون

قالب بندی رشته ها در پایتون

توابع چاپ و ورودی در پایتون

توابع دستکاری تاریخ در پایتون

تمرین - توابع از پیش تعریف شده در پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - توابع تعریف شده توسط کاربر:

توسعه توابع تعریف شده توسط کاربر در پایتون - مقدمه

تعریف توابع در پایتون

رشته های سند در پایتون

برگرداندن متغیرها از توابع پایتون

انتقال پارامترها و آرگومان های تابع به توابع پایتون

تغییر آرگومان ها در پایتون

آرگومان های کلیدواژه در پایتون

خلاصه توابع تعریف شده توسط کاربر در پایتون

انتقال توابع به عنوان آرگومان به توابع پایتون

توابع لامبدا یا ناشناس در پایتون

استفاده از توابع لامبدا در توابع پایتون

تمرین - توابع تعریف شده توسط کاربر در پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - نمای کلی مجموعه ها - لیست و مجموعه:

نمای کلی مجموعه ها در پایتون - لیست و مجموعه - مقدمه

نمای کلی لیست و مجموعه در پایتون

عملیات رایج در مجموعه های پایتون

دسترسی به عناصر از لیست پایتون

افزودن عناصر به لیست پایتون

به روز رسانی و حذف عناصر از Python lis

عملیات دیگر یا متفرقه لیست پایتون

افزودن و حذف عناصر با استفاده از مجموعه پایتون

عملیات مجموعه معمولی پایتون

اعتبار سنجی مجموعه های پایتون

استفاده از لیست و مجموعه پایتون

تمرین - عملیات پایه در لیست و مجموعه پایتون

فهرست پایتون رشته های محدود شده

مرتب سازی داده ها در لیست ها و تاپل های پایتون

مرتبسازی فهرست رشتههای محدود شده با استفاده از پایتون

تمرین - مرتب سازی لیست ها و مجموعه ها در پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - نمای کلی مجموعه ها - dict و tuple:

دستکاری مجموعه ها با استفاده از حلقه ها در پایتون - مقدمه

مروری بر دستور و تاپل پایتون

عملیات رایج در dict و tuple با استفاده از پایتون

دسترسی به عناصر از تاپل های پایتون

دسترسی به عناصر از دستور Python

دستکاری دستور پایتون

نمونه های متداول Python dict

نمایش جداول یا برگه های اکسل به عنوان لیست تاپل ها در پایتون

نمایش جداول یا برگه های اکسل به عنوان فهرست دستورات پایتون

مقادیر دیکت پایتون را پردازش کنید

پردازش آیتم های دیکت پایتون

مرتبسازی موارد دستور پایتون

تمرینات - مروری بر مجموعه های پایتون - دیکت و تنظیم کنید

ضرورت های برنامه نویسی با استفاده از پایتون - دستکاری مجموعه ها با استفاده از حلقه ها:

دستکاری مجموعه ها با استفاده از حلقه ها در پایتون - مقدمه

خواندن فایل ها در مجموعه های پایتون

مروری بر تبدیل استاندارد

تبدیل سطح ردیف با استفاده از حلقه های پایتون

دریافت عناصر منحصر به فرد با استفاده از حلقه های پایتون

فیلتر کردن داده ها با استفاده از حلقه ها و شرطی های پایتون

آماده سازی مجموعه داده ها

بازنگری سریع عملیات دیکت پایتون

اجرای مجموع تجمعات با استفاده از حلقه های پایتون

مروری بر انبوه های گروه بندی شده با استفاده از حلقه های پایتون

با استفاده از حلقههای پایتون، تعداد سفارش را بر اساس وضعیت دریافت کنید

جزئیات درآمد هر سفارش را با استفاده از حلقه های پایتون دریافت کنید

با استفاده از حلقه های پایتون، تعداد سفارش ها را بر اساس ماه دریافت کنید

پیوستن به مجموعه داده ها با استفاده از حلقه های پایتون

دستکاری مجموعه ها با استفاده از Comprehensions در پایتون

فهرست درک با استفاده از پایتون

درک مفاهیم را با استفاده از پایتون تنظیم کنید

Dict Comprehensions در پایتون

محدودیت های استفاده از حلقه ها برای پردازش مجموعه داده ها

تمرین - دستکاری مجموعه ها با استفاده از حلقه های پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - توسعه API های کاهش نقشه:

با استفاده از حلقه ها و شرطی های پایتون، تابع myFilter را توسعه دهید

myFilter را با استفاده از حلقهها و شرطیهای پایتون تأیید کنید

با استفاده از حلقه های پایتون، تابع myMap را توسعه دهید

عملکرد myMap را با استفاده از حلقههای پایتون تأیید کنید

با استفاده از حلقه های پایتون، تابع myReduce را توسعه دهید

با استفاده از حلقههای پایتون، تابع myReduce را تأیید کنید

با استفاده از حلقه های پایتون، تابع myReduceByKey را توسعه دهید

عملکرد myReduceByKey را با استفاده از حلقههای پایتون تأیید کنید

با استفاده از حلقه های پایتون، تابع myJoin را توسعه دهید

عملکرد myJoin را با استفاده از حلقههای پایتون تأیید کنید

تمرینها - توسعه APIهای کاهش نقشه با استفاده از حلقهها و شرطهای پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - درک کتابخانه های کاهش نقشه:

آماده سازی مجموعه داده ها

فیلتر کردن داده ها با استفاده از فیلتر پایتون

پخش داده ها با استفاده از نقشه پایتون

سطح ردیف Transformations با استفاده از نقشه پایتون

تجمعات با استفاده از پایتون کاهش می یابد

درآمد برای شناسه محصول معین با استفاده از Python Map Reduce دریافت کنید

دریافت کل اقلام فروخته شده و کاهش درآمد برای یک محصول با استفاده از نقشه پایتون

با استفاده از Python Map Reduce مبلغ کل کمیسیون را دریافت کنید

نمای کلی itertools

عملیات تجمعی با استفاده از itertools پایتون

استفاده از starmap itertools پایتون

نمای اجمالی itertools Python groupby

با استفاده از Python itertools groupby، تعداد سفارش ها را بر اساس وضعیت دریافت کنید

به ازای هر سفارش با استفاده از itertools groupby پایتون درآمد کسب کنید

محدودیت های نقشه پایتون کتابخانه ها را کاهش می دهد

تمرین - آشنایی با نقشه Python Reduce Libraries

مبانی برنامه نویسی با استفاده از پایتون - مبانی فایل IO با استفاده از پایتون:

مبانی فایل IO با استفاده از پایتون - مقدمه

نمای کلی فایل IO با استفاده از پایتون

مفاهیم پشت پوشه ها و فایل ها را درک کنید

دریافت مسیرهای فایل و نام فایل

نمای کلی داده های خرده فروشی

خواندن فایل متنی به رشته با استفاده از Python File I/O

با استفاده از Python File I/O رشته را در فایل متنی بنویسید

نمای کلی حالتهای نوشتن در فایلها با استفاده از Python File I/O

نمای کلی رشته های محدود شده

csv را در لیست رشته ها با استفاده از Python File I/O بخوانید

نوشتن رشته ها برای فایل در حالت الحاق با استفاده از Python File I/O

مدیریت فایلها و پوشهها با استفاده از Python File I/O

ضرورت های برنامه نویسی با استفاده از پایتون - فایل ها و مجموعه های محدود شده:

آشنایی با فایل ها و مجموعه های محدود شده

نمای کلی فایل های متنی محدود شده

بازنویسی IO فایل اصلی با استفاده از پایتون

فایلهای جدا شده را با استفاده از Python File I/O در فهرست تاپلها بخوانید

رشته های محدود شده را با استفاده از Python File I/O در فایل ها بنویسید

نمای کلی ماژول CSV پایتون برای پردازش فایل ها

داده های محدود شده را با استفاده از APIهای Python CSV بخوانید

نوشتن تکرارپذیر روی فایلها با استفاده از APIهای Python CSV

مزایای استفاده از APIها در ماژول CSV پایتون

Schema را روی لیست های فایل ها با استفاده از پایتون اعمال کنید

ضرورت های برنامه نویسی با استفاده از پایتون - مروری بر کتابخانه های پانداها:

نمای کلی کتابخانه های پایتون پانداها

درک ساختارهای داده پاندای پایتون

نمای کلی سری پایتون

ایجاد فریم های داده پایتون از لیست ها

عملیات اساسی در فریم های داده پایتون

خواندن داده ها از فایل های CSV به فریم های داده پایتون پاندا

پروژهسازی و فیلتر کردن با استفاده از APIهای قاب داده پایتون پاندا

اجرای مجموع تجمعات با استفاده از APIهای قاب داده Python Pandas

اجرای ادغام های گروه بندی شده با استفاده از APIهای قاب داده پایتون پاندا

نوشتن قاب های داده پایتون پانداها در فایل ها

پیوستن داده ها در قاب های داده پایتون پانداها با استفاده از join

ضرورت های برنامه نویسی با استفاده از پایتون - برنامه نویسی پایگاه داده - عملیات CRUD:

عملیات پایگاه داده با استفاده از پایتون - عملیات CRUD - مقدمه

مروری بر برنامه نویسی پایگاه داده با استفاده از پایتون

خلاصه مفاهیم RDBMS

راه اندازی کتابخانه های سرویس گیرنده پایگاه داده برای برنامه های کاربردی پایتون

توسعه تابع برای دریافت اتصال پایگاه داده با استفاده از پایتون

ایجاد جدول پایگاه داده در Postgres با استفاده از پایتون

درج داده ها در جدول در Postgres با استفاده از پایتون

به روز رسانی داده های جدول موجود در Postgres با استفاده از پایتون

حذف داده ها از جدول در Postgres با استفاده از پایتون

پرس و جو داده ها از جدول در Postgres با استفاده از پایتون

Recap - عملیات CRUD با استفاده از پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - برنامه نویسی پایگاه داده - عملیات دسته ای:

برنامه نویسی پایگاه داده با استفاده از پایتون - عملیات دسته ای - مقدمه

بازنویسی Insert با استفاده از Python

آماده سازی پایگاه داده برای انجام عملیات دسته ای با استفاده از پایتون

خواندن داده ها از فایل با استفاده از Python File I/O

بارگیری دسته ای داده ها در جدول پایگاه داده با استفاده از پایتون

بهترین روش ها برای بارگذاری دسته ای در جدول پایگاه داده با استفاده از پایتون

ضرورت های برنامه نویسی با استفاده از پایتون - پردازش داده های JSON:

پردازش داده های JSON - مقدمه

JSON را با استفاده از پاندای پایتون پردازش کنید

انواع داده JSON

رشته JSON ایجاد کنید

روش JSON را پردازش کنید

یک سند JSON در فایلها

چندین سند JSON در فایل ها

JSON را با استفاده از پانداها پردازش کنید

فرمت های مختلف JSON که توسط پایتون پانداها پشتیبانی می شوند

موارد استفاده رایج برای JSON

با استفاده از ماژول پایتون json در فایل های JSON بنویسید

با استفاده از پایتون پانداها در فایل های JSON بنویسید

ضرورت های برنامه نویسی با استفاده از پایتون - پردازش بارهای REST:

نمای کلی REST API

استفاده از دستور curl

مروری بر پستچی

شروع با ماژول درخواست های پایتون

REST Payload را به اشیاء پایتون تبدیل کنید

REST Payload را با استفاده از عملیات مجموعه Python پردازش کنید

REST Payload را با استفاده از Python Pandas پردازش کنید

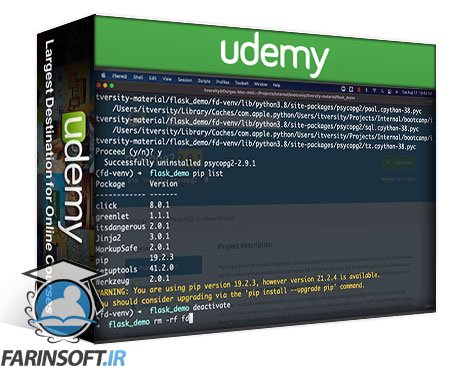

آشنایی با محیط های مجازی پایتون:

مقدمه ای بر محیط های مجازی پایتون

اعتبار سنجی نسخه های پایتون

محیط مجازی پایتون را برای برنامه وب ایجاد کنید

بررسی وابستگی های نصب شده در محیط مجازی پایتون

نصب وابستگی برای برنامه وب با استفاده از Python pip

دریافت جزئیات در مورد بسته های نصب شده با استفاده از پیپ پایتون

پکیج ها را با استفاده از پیپ پایتون حذف نصب کنید

پاکسازی محیط مجازی پایتون

بازسازی و فعال سازی محیط مجازی پایتون برای برنامه وب

تعریف فایل مورد نیاز برای برنامه وب پایتون

نصب Dependencies با استفاده از فایل نیازمندی ها برای برنامه وب پایتون

ایجاد محیط مجازی برای برنامه مهندسی داده با استفاده از پایتون

وابستگی ها را برای برنامه مهندسی داده با استفاده از پایتون نصب کنید

نصب Dependencies برای برنامه مهندسی داده با استفاده از Python 3.6

اعتبار پایتون و سازگاری بسته و نصب پایتون 3.6

نتیجه گیری در مورد درک محیط های مجازی پایتون

نمای کلی Pycharm برای توسعه برنامه پایتون:

معرفی Pycharm برای توسعه اپلیکیشن پایتون

نصب Pycharm در ویندوز برای توسعه برنامه پایتون

نصب Pycharm در مک برای توسعه برنامه پایتون

راه اندازی پروژه شروع پایتون با استفاده از Pycharm

راه اندازی پروژه شروع پایتون با استفاده از Pycharm در مک

راه اندازی پروژه دمو پایتون با استفاده از Pycharm

دسترسی به تنظیمات در Pycharm و تغییر اندازه قلم

دسترسی به تنظیمات در Pycharm و تغییر اندازه قلم در مک

بسته های پایتون را با استفاده از Pycharm نصب کنید

نمای کلی ترمینال مجتمع Pycharm

نمای کلی ترمینال یکپارچه Pycharm در مک

مروری بر آرگومانهای زمان اجرا برای برنامههای پایتون

انتقال آرگومان های زمان اجرا به برنامه های پایتون با استفاده از Pycharm

کپی داده - شروع به کار:

مقدمه ای بر شروع برای کپی داده با استفاده از پایتون

بیانیه مشکل - کپی داده با استفاده از پایتون

ایجاد دایرکتوری کاری برای پروژه پایتون

Setup Docker در Windows 10 Pro

نمایش اجمالی سریع Docker

مجموعه داده را آماده کنید

کانتینر Postgres را ایجاد کنید

پایگاه داده Postgres را برای توسعه راه اندازی کنید

مروری بر دستورات پایگاه داده Postgres

راه اندازی پروژه پایتون با استفاده از Pycharm

مدیریت وابستگی های پایتون برای پروژه

پروژه GitHub را ایجاد کنید

کپیکننده داده - خواندن دادهها با استفاده از پاندا:

خواندن داده ها با استفاده از پاندای پایتون - مقدمه

نمای کلی داده های خرده فروشی

افزودن پاندای پایتون به پروژه

خواندن داده های JSON با استفاده از پایتون پاندا

پیش نمایش داده ها با استفاده از پایتون پاندا

خواندن داده ها در تکه ها با استفاده از پاندای پایتون

خواندن پویا فایل ها با استفاده از ماژول سیستم عامل پایتون

کپی داده - برنامه نویسی پایگاه داده با استفاده از پاندا:

برنامه نویسی پایگاه داده با استفاده از پایتون پاندا - مقدمه

تنظیم Postgres را با استفاده از Docker تأیید کنید

افزودن وابستگی های مورد نیاز برای برنامه نویسی پایگاه داده با استفاده از پانداهای پایتون

جدول کاربران را در پایگاه داده retail_db ایجاد کنید

پر کردن داده های نمونه در جدول کاربران

خواندن داده ها از جدول با استفاده از پایتون پاندا

جدول پایگاه داده Postgres کاربران را کوتاه کنید

نوشتن Python Pandas Dataframe در جدول

اعتبار سنجی داده های کاربران در جدول پایگاه داده Postgres

جدول پایگاه داده Postgres کاربران را رها کنید

کپیکننده داده - بارگیری دادهها از فایلها به جداول:

بارگیری داده ها از فایل ها به جداول - مقدمه

جمع کردن داده های بخش ها در جدول

تأیید جدول بخش ها

پر کردن جدول سفارشات به صورت تکهای با استفاده از پایتون پاندا

تأیید جدول سفارشات در پایگاه داده Postgres

تأیید جدول سفارشات با استفاده از پانداها

Data Copier - مدولار کردن برنامه:

نمای کلی تابع اصلی پایتون

مروری بر متغیرهای محیط پایتون

استفاده از ماژول سیستم عامل پایتون برای متغیرهای محیطی

انتقال متغیرهای محیطی به برنامه های پایتون با استفاده از Pycharm

منطق را با استفاده از پاندای پایتون بخوانید

اعتبار منطق خواندن توسعه یافته با استفاده از پایتون پانداها را تأیید کنید

منطق را با استفاده از پاندای پایتون بنویسید

اعتبار نوشتن منطق توسعه یافته با استفاده از پایتون پاندا را تأیید کنید

منطق خواندن و نوشتن را با استفاده از پایتون ادغام کنید

اعتبار منطق یکپارچه سازی توسعه یافته با استفاده از پایتون

منطق را برای بارگذاری چندین جدول با استفاده از پایتون توسعه دهید

منطق پایتون را برای لیست جدول به عنوان آرگومان زمان اجرا اعتبار سنجی کنید

تغییرات برنامه پایتون را به مخزن git راه دور فشار دهید

Data Copier - Dockering برنامه:

Docker کردن برنامه - مقدمه

پایگاه داده را برای اعتبار سنجی آماده کنید

تصویر پایتون مناسب را بکشید و اعتبار سنجی کنید

شبکه را به ظرف داکر پایگاه داده ایجاد و وصل کنید

یک جمع بندی سریع درباره کانتینرهای Docker

برنامه کپی داده مبتنی بر پایتون را مرور کنید

استقرار برنامه پایتون و نصب وابستگی ها در کانتینر داکر

فایل های داده منبع را در ظرف کپی کنید

ظرف کپی داده پایتون را به شبکه سفارشی اضافه کنید

نصب کتابخانه های سیستم عامل به عنوان بخشی از ظرف Docker

تأیید اتصال شبکه بین کانتینرهای Docker

اجرای برنامه از کانتینر Docker

حذف Docker Container

Data Copier - با استفاده از Docker Image سفارشی:

استفاده از تصویر داکر سفارشی - مقدمه

دریافت کنیدting با تصویر سفارشی docker شروع شد

ماژول های سیستم عامل را در تصویر داکر سفارشی نصب کنید

کپی کد منبع پایتون در تصویر سفارشی Docker

افزودن وابستگی ها به تصویر سفارشی

آشنایی با فرآیند ساخت تصویر سفارشی داکر

نصب پوشههای داده در Docker Container

عبور متغیرهای محیطی به Docker Container

Container Data Copier Python را به شبکه سفارشی اضافه کنید

برنامه پایتون را با استفاده از داکر اجرا کنید

Data Copier - استقرار و اعتبارسنجی برنامه در سرور راه دور:

استقرار و اعتبارسنجی برنامه پایتون در سرور راه دور - مقدمه

تغییرات برنامه را به مخزن GitHub فشار دهید

شرایط لازم برای استقرار برنامه در ماشین مجازی

برنامه کلون در دستگاه راه دور

تنظیم مجموعه داده برای اعتبارسنجی

تنظیم پوشه شبکه و پایگاه داده برای پایگاه داده با استفاده از Docker

کانتینر داکر را برای پایگاه داده راه اندازی کنید

پایگاه داده و جداول را به عنوان بخشی از سرور پایگاه داده مبتنی بر Docker تنظیم کنید

ساخت تصویر Docker سفارشی برای برنامه

برنامه Dockerized را اجرا و اعتبار سنجی کنید

تنظیم گره Hadoop و Spark Cluster یا Lab با استفاده از Docker:

تنظیم Hadoop Single Node و Spark Cluster یا Lab با استفاده از Docker

پیش نیازهای راه اندازی Hadoop و Spark Lab

پیکربندی Docker Desktop

محتوای Hadoop و Spark را بهروزرسانی کنید

برای راه اندازی و یادگیری Hadoop و Spark، مخزن GitHub را کلون کنید

پاکسازی کانتینرهای Docker مورد استفاده برای Python و SQL Practice

جزئیات Hadoop و Spark Lab را در Docker Compose File مرور کنید

Pull Docker Image for Single Node Hadoop و Spark

کانتینرهای Docker مربوط به Hadoop و Spark را راه اندازی کنید

مروری بر بررسی راهاندازی Hadoop و Spark Lab با استفاده از Docker

اتصال به ترمینال کانتینرهای اسپارک و هادوپ

HDFS و YARN را در Single Node Hadoop و Spark Cluster مرور کنید

HIve را در Hadoop Single Node و Spark Cluster مرور و اعتبارسنجی کنید

اعتبار سنجی Spark 2 با استفاده از Pyspark و Spark SQL در Single Node Lab

اعتبار سنجی Spark 3 با استفاده از Pyspark و Spark SQL در Single Node Lab

اعتبار سنجی متاستور HIve که به عنوان بخشی از Hadoop و Spark Cluster Single Node استفاده می شود

با استفاده از محیط آزمایشگاه Jupyter به مواد Hadoop و Spark دسترسی پیدا کنید

مدیریت Hadoop تک گره و Spark Cluster با استفاده از Docker

معرفی سیستم اکو Hadoop - مروری بر HDFS:

دریافت کمک یا استفاده

فهرست کردن فایل های HDFS

مدیریت فهرست راهنمای HDFS

کپی کردن فایل ها از محلی به HDFS

کپی کردن فایل ها از HDFS به محلی

دریافت فراداده فایلها

پیش نمایش داده ها در فایل های HDFS

اندازه بلوک HDFS

فاکتور تکرار HDFS

دریافت استفاده از فضای ذخیره سازی HDFS

استفاده از دستورات آمار HDFS

مجوزهای فایل HDFS

ویژگی های فراگیر

مهندسی داده با استفاده از Spark SQL - شروع به کار:

شروع به کار - نمای کلی

مروری بر مستندات Spark

راه اندازی و استفاده از Spark SQL CLI

مروری بر ویژگی های Spark SQL

اجرای دستورات سیستم عامل با استفاده از Spark SQL

آشنایی با فهرست انبار

مدیریت پایگاه های داده Spark Metastore

مدیریت جداول Spark Metastore

فراداده جداول را بازیابی کنید

نقش Spark Metastore یا Hive Metastore

ورزش - شروع کار با Spark SQL

مهندسی داده با استفاده از Spark SQL - Basic Transformations :

تحولات اساسی - مقدمه

Spark SQL - نمای کلی

بیان مشکل را تعریف کنید

جداول را آماده کنید

پروژهگذاری دادهها

فیلتر کردن داده ها

میزهای پیوستن - داخلی

اتصال جداول - بیرونی

داده های تجمیع

مرتب سازی داده ها

نتیجه گیری - راه حل نهایی

مهندسی داده با استفاده از Spark SQL - مدیریت جداول - پایه DDL و DML:

مقدمه

جداول Spark Metastore را ایجاد کنید

مروری بر انواع داده ها

افزودن نظرات

بارگیری داده ها در جداول - محلی

بارگیری داده ها در جداول - HDFS

بارگیری داده - اضافه و بازنویسی

ایجاد جداول خارجی

جدول مدیریت شده در مقابل جداول خارجی

نمای کلی فرمت های فایل

جداول و پایگاه داده را رها کنید

قطع کردن جداول

تمرین - جداول مدیریت شده

مهندسی داده با استفاده از Spark SQL - مدیریت جداول - DML و پارتیشن بندی:

مقدمه - مدیریت جداول - DML و پارتیشن بندی

مقدمه ای بر پارتیشن بندی

ایجاد جداول با استفاده از پارکت

بارگیری در مقابل درج

درج داده ها با استفاده از جدول مرحله

ایجاد جداول پارتیشن بندی شده

افزودن پارتیشن به جداول

بارگیری داده ها در جداول پارتیشن بندی شده

درج داده ها در پارتیشن ها

استفاده از حالت پارتیشن پویا

تمرین - جداول تقسیم شده

مهندسی داده با استفاده از Spark SQL - مروری بر توابع Spark SQL:

مقدمه - مروری بر توابع Spark SQL

نمای اجمالی توابع

توابع اعتبارسنجی

توابع دستکاری رشته

توابع دستکاری تاریخ

نمای کلی توابع عددی

تبدیل نوع داده

برخورد با Nulls

استفاده از CASE و WHEN

مثال پرس و جو - تعداد کلمات

مهندسی داده با استفاده از Spark SQL - توابع پنجره:

مقدمه - توابع پنجره

پایگاه داده منابع انسانی را آماده کنید

نمای کلی عملکردهای پنجره

تجمیع با استفاده از توابع پنجره

استفاده از LEAD یا LAG

دریافت اولین و آخرین مقادیر

رتبه بندی با استفاده از توابع پنجره

ترتیب اجرای SQL.cmproj

نمای کلی سوالات فرعی

فیلتر کردن نتایج عملکرد پنجره

Apache Spark با استفاده از Python - بررسی اجمالی پردازش داده:

شروع Spark Context - pyspark

نمای کلی Spark Read APIها

درک اطلاعات خطوط هوایی

استنتاج طرحواره

پیش نمایش داده های خطوط هوایی

نمای کلی APIهای Data Frame

نمای اجمالی توابع

نمای کلی Spark Write API

Apache Spark با استفاده از پایتون - پردازش داده های ستون:

نمای کلی توابع از پیش تعریف شده در Spark

فریم داده ساختگی ایجاد کنید

دسته های توابع

عملکردهای ویژه - کول و روشن

توابع متداول دستکاری رشته

استخراج رشته ها با استفاده از رشته فرعی

استخراج رشته ها با استفاده از split

پرداختن نویسهها در اطراف رشتهها

برش کاراکترها از رشته ها

توابع دستکاری تاریخ و زمان

تاریخ و زمان محاسبات

استفاده از توابع تاریخ و زمان Trunc

توابع استخراج تاریخ و زمان

استفاده از to_date و to_timestamp

استفاده از تابع date_format

برخورد با Unix Timestamp

برخورد با Nulls

استفاده از CASE و WHEN

Apache Spark با استفاده از Python - Basic Transformations :

بررسی اجمالی تحولات اساسی

فریم های داده برای تبدیل های اساسی

فیلتر اولیه داده ها

فیلتر کردن مثال با استفاده از تاریخ

اپراتورهای بولی

استفاده از عملگر IN یا تابع isin

استفاده از LIKE Operator یا like Function

استفاده از عملگر BETWEEN

برخورد با Nulls هنگام فیلتر کردن

مجموع تجمعات

داده ها را با استفاده از groupBy جمع آوری کنید

دادهها را با استفاده از جمعآوری جمعآوری کنید

داده ها را با استفاده از cube.cmproj جمع آوری کنید

مروری بر مرتبسازی فریمهای داده

راه حل - مسئله 1 - جمع آوری کل را دریافت کنید

راه حل - مسئله 2 - جمع آوری کل بر اساس FlightDate

Apache Spark با استفاده از پایتون - پیوستن به مجموعه داده ها:

مجموعه داده ها را برای پیوستن آماده کنید

تجزیه و تحلیل مجموعه داده ها برای پیوستن

بیانات مشکل برای پیوستن

نمای کلی Joins

استفاده از اتصالات داخلی

پیوستن بیرونی چپ یا راست

راه حل - دریافت تعداد پرواز در هر فرودگاه ایالات متحده

راه حل - دریافت تعداد پرواز در هر ایالت ایالات متحده

راه حل - فرودگاه های خفته ایالات متحده را دریافت کنید

راه حل - بدون داده اصلی، Origins را دریافت کنید

راه حل - تعداد پروازها را بدون داده اصلی دریافت کنید

راه حل - تعداد پروازهای هر فرودگاه را بدون داده اصلی دریافت کنید

راه حل - درآمد روزانه دریافت کنید

راه حل - دریافت درآمد روزانه تا سالانه

Apache Spark با استفاده از Python - Spark Metastore:

نمای کلی Spark Metastore

کاوش کاتالوگ Spark

ایجاد جداول متاستور با استفاده از کاتالوگ

استنتاج طرحواره برای جداول

شما را برای جداول با استفاده از StructType تعریف کنید

درج در جداول موجود

داده ها را از جداول متاستور بخوانید و پردازش کنید

جداول پارتیشن بندی شده ایجاد کنید

ذخیره به عنوان جدول پارتیشن بندی شده

ایجاد نماهای موقت

استفاده از Spark SQL

Apache Spark - چرخه حیات توسعه با استفاده از پایتون:

محیط مجازی را راه اندازی کرده و Pyspark را نصب کنید

[Commands] - محیط مجازی را راه اندازی کرده و Pyspark را نصب کنید

شروع با Pycharm

[کد و دستورالعمل] - شروع به کار با Pycharm

گذراندن آرگومان های زمان اجرا

دسترسی به متغیرهای محیط سیستم عامل

شروع با Spark

ایجاد تابع برای Spark Session

[Code and Instructions] - ایجاد تابع برای Spark Session

تنظیم داده های نمونه

خواندن داده ها از فایل ها

[کد و دستورالعمل ها] - خواندن داده ها از فایل ها

پردازش داده ها با استفاده از Spark API

[Code and Instructions] - پردازش داده ها با استفاده از Spark API

داده ها را در فایل ها بنویسید

[کد و دستورالعمل ها] - داده ها را در فایل ها بنویسید

اعتبار سنجی نوشتن داده ها در فایل ها

تولید کد

[کد و دستورالعمل] - تولید کد

تنظیم داده ها برای اعتبارسنجی تولید

اجرای برنامه با استفاده از YARN

اعتبار سنجی دقیق برنامه

Data Engineering Essentials Hands-on - SQL, Python and Spark

در این روش نیاز به افزودن محصول به سبد خرید و تکمیل اطلاعات نیست و شما پس از وارد کردن ایمیل خود و طی کردن مراحل پرداخت لینک های دریافت محصولات را در ایمیل خود دریافت خواهید کرد.

فیلم یادگیری کامل Spark SQL, Spark 3 و استفاده از Scala

Mastering Databricks SQL Warehouse and Spark SQL

آموزش کدنویسی Apache Spark 2022 و Databricks در آن

Master Data Engineering using Azure Data Analytics

مسلط شدن بر Amazon Redshift و مبحث Serverless

مهندسی دیتا بوسیله سرویس های AWS Analytics

-main-resized.jpg)

کورس کدنویسی Spark SQL and PySpark 3 در زبان پایتون

Master Data Engineering using GCP Data Analytics

مهندسی داده ها با استفاده از Databricks در AWS و Azure

اطلاع رسانی حذف دوره های قدیمی و تخفیفات نوروزی مشاهده