در حال حاضر محصولی در سبد خرید شما وجود ندارد.

این دوره به شما آموزش خواهد داد که چگونه بهینه سازی عملکرد خوشه های جرقه در Databricks Azure را با شناسایی و کاهش مسائل مختلف مانند مشکلات مصرف اطلاعات و تنگناها عملکرد

آنچه شما یاد می گیرید

موتور Apache Spark Accelytics Unified analytics چارچوب بسیار سریع و اجرا برای پردازش داده های بزرگ. با این حال، شما ممکن است متوجه شوید که کد جرقه Apache شما در حال اجرا در Databricks Azure هنوز از تعدادی از مسائل رنج می برد. این می تواند به دلیل مشکل در مصرف اطلاعات به شیوه ای قابل اعتماد از منابع مختلف یا به دلیل مسائل مربوط به عملکرد که شما به دلیل دیسک I / O، عملکرد شبکه یا تنگناهای محاسباتی مواجه می شوید.

در این دوره، بهینه سازی Apache Spark در Databricks، شما ابتدا بررسی و درک مسائلی که ممکن است با مصرف داده ها به یک مخزن متمرکز برای پردازش داده ها و استخراج بینش مواجه شوید. پس از آن، شما خواهید آموخت که چگونه Delta Lake در Databricks Azure به شما اجازه می دهد تا داده ها را برای پردازش، بینش، و همچنین یادگیری ماشین در جداول دلتا ذخیره کنید و خواهید دید که چگونه می توانید مشکلات مصرف اطلاعات خود را با استفاده از لودر خودکار در Databricks به داده های جریان داده ها کاهش دهید .

NEXT، شما به احتمال زیاد در هنگام پردازش داده ها در جرقه آپاچی، مسائل مربوط به سریال سازی، سوء استفاده، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، نشت، از بین بردن، را بررسی کنید. شما تکنیک هایی را برای کاهش این مسائل یاد خواهید گرفت و ببینید که چگونه می توانید عملکرد کد پردازش خود را با استفاده از پارتیشن بندی دیسک، خوشه بندی z-order و bucketing بهبود بخشید.

در نهایت، شما خواهید آموخت که چگونه می توانید منابع را با استفاده از خوشه به اشتراک بگذارید برنامه ریزی استخر ها و برنامه ریزی منصفانه و نحوه عملکرد دیسک خواندن و نوشتن عملیات با استفاده از ذخیره سازی در جداول دلتا.

هنگامی که شما با این دوره به پایان رسید، مهارت و دانش بهینه سازی عملکرد در جرقه مورد نیاز برای به دست آوردن بهترین ها را داشته باشید خارج از خوشه جرقه شما.

عنوان اصلی : Optimizing Apache Spark on Databricks

سرفصل های دوره :

مرور دوره

پیش نیازها و طرح درس

Delta Lake

اطلاعات مصرف: تعریف، چالش ها و بهترین شیوه ها

لودر خودکار برای مصرف اطلاعات

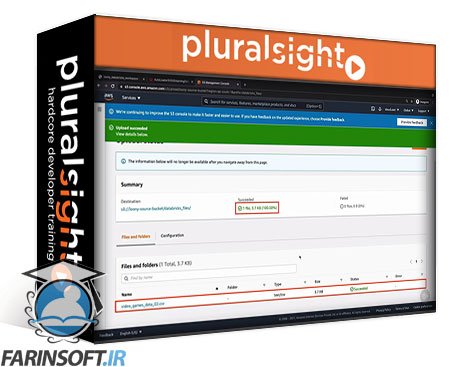

نسخه ی نمایشی: ایجاد یک منبع ذخیره سازی ابر خارجی برای مصرف فایل ها

نسخه ی نمایشی: مصرف داده های جریان به دریاچه دلتا

نسخه ی نمایشی: ردیابی فایل های پردازش شده با استفاده از لودر خودکار

نسخه ی نمایشی: مصرف اطلاعات دسته ای به Delta Lake

نسخه ی نمایشی: مصرف داده ها به دریاچه دلتا با استفاده از SQL

اطلاعات Databricks اطلاعات شبکه

مسائل مربوط به عملکرد در جرقه

تنگناهای عملکرد در جرقه: سریال سازی و skew

تنگناها عملکرد در جرقه: نشت، زدن، و حافظه

پارتیشن های حافظه و پارتیشن های دیسک

نسخه ی نمایشی: پارتیشن بندی دیسک

پرش داده ها و خوشه بندی Z-Order

نسخه ی نمایشی: z سفارش در یک جدول دلتا کوچک

نسخه ی نمایشی: z سفارش بر روی یک جدول دلتا بزرگ

Bucketing برای بهینه سازی پیوستن

نسخه ی نمایشی: جداول سطل و تاسیسات

نسخه ی نمایشی: پیوستن به سطل های سطحی و جداول Unfucketed

FIFO و برنامه ریزان نمایشگاه

نسخه ی نمایشی: برنامه ریزی پیش فرض Pool Fifo

نسخه ی نمایشی: پیکربندی استخرهای مختلف برای به اشتراک گذاشتن منابع

Delta Cache

نسخه ی نمایشی: پیکربندی کش دلتا بر روی یک خوشه

نسخه ی نمایشی: در حال اجرا پرس و جو در داده های ذخیره شده

ویژگی های جدید در Apache Spark 3.0

خلاصه و مطالعه بیشتر

Optimizing Apache Spark on Databricks

در این روش نیاز به افزودن محصول به سبد خرید و تکمیل اطلاعات نیست و شما پس از وارد کردن ایمیل خود و طی کردن مراحل پرداخت لینک های دریافت محصولات را در ایمیل خود دریافت خواهید کرد.

پایه های آمار و احتمال برای یادگیری ماشینی

Kubernetes: زیرساخت به عنوان کد با Pulumi

Implementing Machine Learning Workflow with Weka

AI Workshop: Hands-on with GANs Using Dense Neural Networks

Data Labeling for Machine Learning

فیلم یادگیری کامل Evaluating a Data Mining Model

Learning JAX

آموزش پیاده سازی روشهای کلاسترینگ با Scikit-learn

آموزش خلاصه سازی داده ها و انجام کارهای آماری مربوط به آن

Style Transfer with PyTorch

✨ تا ۷۰% تخفیف با شارژ کیف پول 🎁

مشاهده پلن ها