در حال حاضر محصولی در سبد خرید شما وجود ندارد.

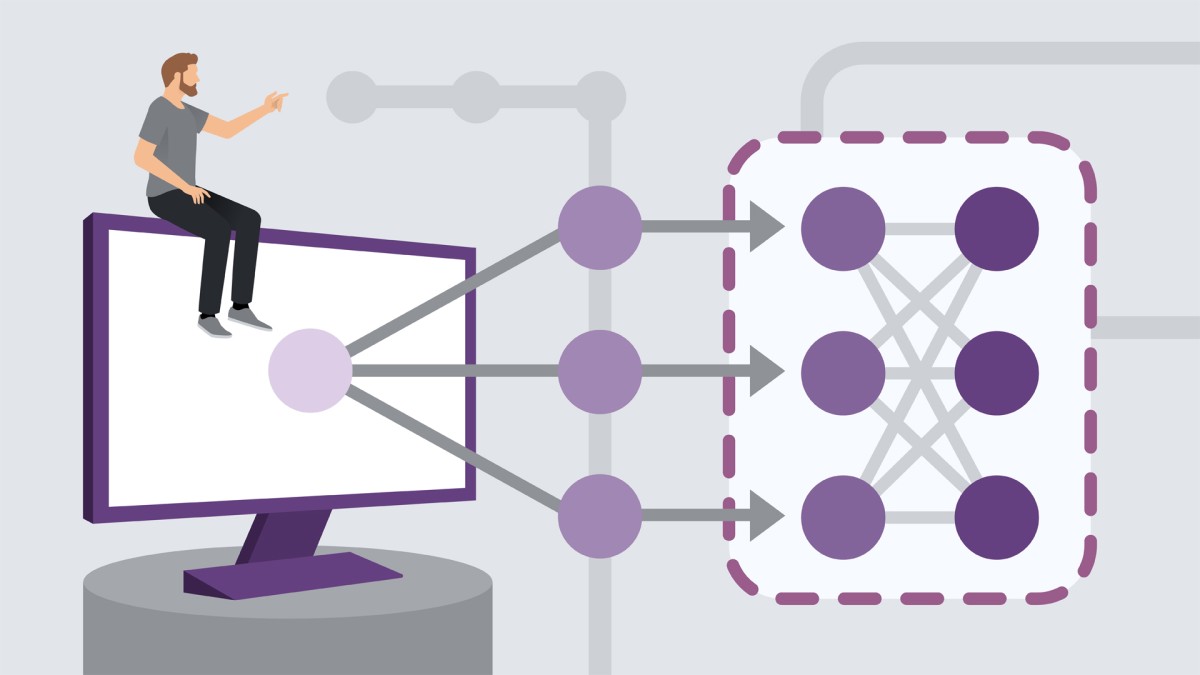

Attention-based models allow neural networks to focus on the most important features of the input, thus producing better results at the output. In this course, Janani Ravi explains how recurrent neural networks work and builds and trains two image captioning models one without attention and another using attention models and compares their results. If you have some experience and understanding of how neural networks work and want to see what attention-based models can do for you, check out this course.

در این روش نیاز به افزودن محصول به سبد خرید و تکمیل اطلاعات نیست و شما پس از وارد کردن ایمیل خود و طی کردن مراحل پرداخت لینک های دریافت محصولات را در ایمیل خود دریافت خواهید کرد.

آموزش داده یابی یا همان Data Mining از متون

Data Labeling for Machine Learning

آموزش دسته بندی عکس ها بوسیله PyTorch

آموزش معماری راهکارهای بیگ دیتا با استفاده از Google Dataproc

Snowpark for Data Engineers

آموزش ترکیب و شکل دادن به داده ها

Building Statistical Summaries with R

Communicating Data Insights

آموزش کاهش ابعاد داده ها با استفاده از Scikit-learn

Scala 2 Methods and Functions

✨ تا ۷۰% تخفیف با شارژ کیف پول 🎁

مشاهده پلن ها