در حال حاضر محصولی در سبد خرید شما وجود ندارد.

اگر شما به دنبال گسترش دانش خود در مهندسی داده هستید یا می خواهید با اضافه کردن برنامه نویسی جرقه به مهارت مهارت خود، نمونه کارها را افزایش دهید، پس شما در جای مناسب قرار دارید. این دوره به شما در درک برنامه نویسی جرقه کمک خواهد کرد و این دانش را برای ساخت راه حل های مهندسی داده ها اعمال می کند. این دوره نمونه ای است که به دنبال یک رویکرد کار مانند کار است. ما یک رویکرد برنامه نویسی زنده و توضیح تمام مفاهیم مورد نیاز در طول مسیر را خواهیم گرفت.

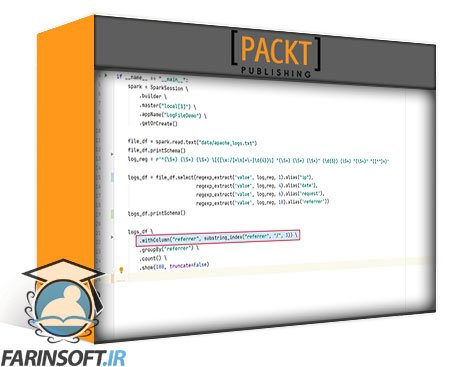

در این دوره، ما با معرفی سریع به جرقه آپاچی شروع خواهیم کرد، سپس محیط زیست ما را با نصب و استفاده از جرقه آپاچی تنظیم می کنیم. بعد، ما در مورد مدل اجرای جرقه و معماری، و در مورد مدل برنامه نویسی جرقه و تجربه توسعه دهنده یاد خواهیم گرفت. بعد، ما بنیاد API ساختاری جرقه را پوشش خواهیم داد و سپس به منابع داده جرقه و غرق می شویم.

سپس ما پس از آن ما را پوشش داده ایم. ما همچنین جمع آوری ها را در جرقه آپاچی پوشش خواهیم داد و در نهایت ما را پوشش خواهیم داد.

در پایان این دوره، شما قادر خواهید بود راه حل های مهندسی داده ها را با استفاده از API ساختاری جرقه در پایتون ایجاد کنید.

همه منابع برای این دوره در https://github.com/packtpublishing/spark-programming-in-python-for-beginners-with-apache-spark-3 در دسترس هستند

عنوان اصلی : Spark Programming in Python for Beginners with Apache Spark 3

سرفصل های دوره :

معرفی آپاچی اسپارک:

تاریخچه کلان داده و پرایمر

درک چشم انداز دریاچه داده

آپاچی اسپارک چیست - مقدمه و مروری

نصب و استفاده از Apache Spark:

محیط های توسعه اسپارک

کاربران مک - Apache Spark در حالت محلی خط فرمان REPL

کاربران ویندوز - Apache Spark در حالت محلی خط فرمان REPL

کاربران مک - Apache Spark در IDE - PyCharm

کاربران ویندوز - Apache Spark در IDE - PyCharm

Apache Spark در Cloud - Databricks Community and Notebooks

آپاچی اسپارک در آناکوندا - نوت بوک Jupyter

مدل و معماری اجرای جرقه:

روش های اجرا - چگونه برنامه های Spark را اجرا کنیم؟

مدل پردازش توزیع شده Spark - برنامه شما چگونه اجرا می شود؟

حالت های اجرای جرقه و مدیران خوشه

خلاصه کردن مدل های اجرای جرقه - چه زمانی از چه چیزی استفاده کنیم؟

کار با PySpark Shell - نسخه ی نمایشی

نصب چند گره Spark Cluster - نسخه نمایشی

کار با نوت بوک در کلاستر - نسخه ی نمایشی

کار با Spark Submit - نسخه نمایشی

خلاصه بخش

مدل برنامه نویسی Spark و تجربه توسعه دهنده:

ایجاد پیکربندی ساخت پروژه Spark

پیکربندی گزارش های برنامه کاربردی پروژه Spark

ایجاد جلسه Spark

پیکربندی Spark Session

معرفی چارچوب داده

پارتیشنها و اجراکنندههای قاب داده

تحولات و اقدامات جرقه

مراحل و وظایف Spark Jobs

درک برنامه اجرایی شما

برنامه اسپارک تست واحد

خلاصه گرد کردن

Spark Structured API Foundation:

معرفی Spark API

معرفی Spark RDD API

کار با Spark SQL

Spark SQL Engine and Catalyst Optimizer

خلاصه بخش

منابع و سینک های داده Spark:

Spark Data Sources and Sinks

Spark DataFrameReader API

خواندن فایلهای CSV، JSON و Parquet

ایجاد Spark DataFrame Schema

Spark DataFrameWriter API

نوشتن داده ها و مدیریت طرح

پایگاه های داده و جداول Spark

کار با جداول Spark SQL

تغییر قاب داده و مجموعه داده Spark:

مقدمه ای بر تبدیل داده ها

کار با ردیف های Dataframe

ردیف دیتا فریم و تست واحد

ردیف های قاب داده و داده های بدون ساختار

کار با ستون های Dataframe

ایجاد و استفاده از UDF

تغییرهای متفرقه

Aggregations در Apache Spark:

تجمیع قالب های داده

گروهبندی تجمیعها

تجمیعهای پنجرهای

پیوستن Spark Dataframe:

ابهام اتصالات قاب داده و نام ستون

اتصالات خارجی در Dataframe

داخلی Spark Join و Shuffle

بهینه سازی جوین های خود

اجرای اتصالات سطلی

به یادگیری ادامه دهید:

واژه پایانی

Spark Programming in Python for Beginners with Apache Spark 3

در این روش نیاز به افزودن محصول به سبد خرید و تکمیل اطلاعات نیست و شما پس از وارد کردن ایمیل خود و طی کردن مراحل پرداخت لینک های دریافت محصولات را در ایمیل خود دریافت خواهید کرد.

✨ تا ۷۰% تخفیف با شارژ کیف پول 🎁

مشاهده پلن ها